| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |

- collectivism

- #크립키

- heartism

- 심리학

- sexdifference

- 강화

- 시각처리

- 빅토리아 시대

- criminal psychology

- 연결주의

- 일주율

- memory

- Psychology

- 도덕발달단계론

- ctm

- 행동주의 치료

- 테스토스테론렉스

- 행동주의

- individualism

- behavior modification

- persuation

- #산업및조직심리학

- 개인주의

- 따뜻함주의

- #정신역동

- 집단주의

- #정신분석

- 켈트 매듭

- celtic knot

- 외측 슬상핵

- Today

- Total

지식저장고

언어과학 총론 본문

(language)의 역사는 실로 오래되었다. 학자들에 따르면 6-7만년전에 구어(spoken language)가 나타났고 문명시대에 들어서면서 문자와 문어가 나타났다. 언어는 인간이 가진 가장 독특한 특성중 하나로, 언어가 나타나면서 사람들은 서로 추상적인 의미를 전달하는게 가능해졌고 이것이 인지적 혁명으로 이어져 지성의 비약적 발전과 문명의 출현을 가져왔다.1 지금도 언어에 대한 이해는 인간의 지성과 문명을 이해하는데 필수적이다.

언어2

언어(language)는 의미를 담고 있으며 문법 규칙에 따라 결합될 수 있는 신호들을 통해 다른 개체와 소통하는 체계이다. 여기서 문법(grammar)은 언어 단위(음소)들을 결합하여 의미있는 메시지를 만드는 규칙들을 말한다. 인간의 언어는 300-100만년 전에 나타났을 것으로 추정되며, 글(문어)은 6000년전에 생겼을 것으로 추측된다. 현재 인류의 언어는 50개 어족에 속하는 4000개 언어로 구성되어 있다.3 언어는 동물들도 가지고 있는 것으로, 벌이나 벨벳 원숭이language)4도 자신들의 독특한 언어체계를 가지고 있다. 특히 벌은 8자 춤을 사용하는 특이한 몸짓 언어를 가지고 있는 것으로 유명하다.5

인간의 언어는 동물의 언어와 많은 부분에서 다르다. 대표적으로 인간의 언어는 상징(symbol)을 통한 의미전달이 가능하다. 동물의 경우에 언어는 iconic(indexical)한, 즉 해당 의미와 비슷한 면이 있어야 한다. 예를 들어 개의 위협행동은 개의 감정상태에 대한 다양한 행동지표(으르렁대는 소리, 부릎뜬 눈, 이빨 등)로 나타나는데, 이 지표들은 실제 개가 전달하고자 하는 의미(나 화났다)와 깊게 관련되어 있다. 이런 특징은 아기들이 사용하는 언어에서도 나타난다. 반면 인간이 화를 낼때 사용하는 '나 화났다','I'm angry'같은 문장이나 외교관 초치와 같은 의식적인 행위는 실제 의미에 대한 직접적인 정보를 담고 있지는 않다. 이것들은 단지 화남에 대한 '상징'으로, 상징을 언어의 수단으로 사용하면서 인간의 언어는 동물보다 좀더 유연한 표현이 가능해졌다.

인간의 언어는 duality of patterning에서도 동물과 다르다. 인간이 사용하는 단어는 매우 다양하지만 모두 2가지의 면을 가진다. 모든 단어들은 여러개의 음소를 모아놓은 음파인데, 동시에 이를 적절히 모아놓으면 기존의 음소가 가진 뜻과는 다른 전혀 새로운 의미가 출현한다. 'tea'라는 단어는 a와 t,e라는 음소로 구성되어 있지만, 이들을 적절히 조합하면 나타나는 tea는 차라는 의미를 가지며, 순서를 다르게 해서 ate나 eta를 만들면 차와는 다른 의미가 출현한다. 언어학에서는 전자를 구문론, 후자를 의미론이라고 하는데, 언어심리학에서는 언어의 구문론적 의미를 표층구조(surface structure)라 하고, 언어의 의미론적 의미를 심층구조(deep structure)라 한다. 둘은 서로 논리적 연관이 없으며, 실제로도 다르게 처리된다.6

언어의 의미론적 의미는 구문론적 의미에서 연역되지 않는다. 즉 음소가 얼마나 있든 음소를 조합하여 언제든 새로운 의미를 창출할수 있기 때문에, 인간은 마치 레고를 가지고 놀듯이 한정된 음소를 가지고 거의 무한에 가까운 의미들을 표현할수 있다. 레고를 가지고 거의 모든 물체를 재현할 수 있듯이, 이처럼 유연한 언어를 가지고 인간은 서로 교역하고, 협상할수 있었으며, 눈에 보이지 않는 대상도 표현하고, 정의하고 다룰수 있게 되었다. 비록 인간이 언어를 통해 사고하는 것은 아니지만,7 언어를 통해 인간은 유일하게 과거와 미래를 표현할 수 있는 동물이며 단어를 조합해서 역설과 아이러니를 만들수 있는 동물이다.

이러한 규칙은 문장에도 적용된다. 인간의 언어는 규칙성을 가지는데, 영어에서 무언가를 하는 사물이나 대상을 지칭하는 단어(주어)는 문장 앞에 들어가야 하고 어떤 행위에 대한 단어(서술어)는 중간에, 행위의 대상을 지칭하는 단어(목적어)는 동사 다음에 있어야 한다. 대신에 어느 단어가 주어나 목적어가 될지는 자유이기 때문에 사람들은 만들어진 문법적 틀에 단어를 집어넣어 거의 무한에 가까운 의미를 창출할 수 있다. 이러한 언어의 조직은 몇가지 수준으로 나뉘는데, 음소 자체의 관계를 다루는 phonemes, 음소를 조합하여 형태소를 구성하는 phonology(phonotactic), 형태소를 조합하여 단어를 만드는 morphology, 그리고 단어로 구와 문장을 조립하는 syntax 수준으로 나눌 수 있다.

언어의 수준

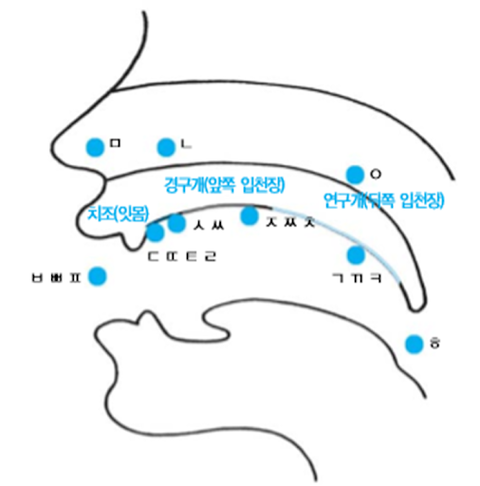

음소(phonome, phonetics, phonology)는 언어가 구성되는 가장 최소한의 단위이다. 그 자체로는 아무 뜻도 가지지 못하며, 음소의 개수는 한정되어 있고 언어마다 약간씩 다르다. 각 언어에서 사용하는 음소의 목록은 IPA에서 찾아볼 수 있다. IPA 차트에서는 음소가 발생하는 위치에 따라 음소를 분류하여 제시하고 있다.(한글도 비슷하게 배운다) 음소를 적절히 조합하면 하나의 뜻을 가지는 형태소를 만들수 있다. 음소를 조합해서 형태소를 만드는데는 일정한 규칙이 있는데,(phonological rule, 음성 규칙) 예를 들어 영어에서 tl은 단어의 중간에만 와야 한다. bottle이나 battle은 되지만, tlbotte나 batetl은 안된다. 비슷하게 한국어에서도 자음은 모음없이 홀로 나타나지 않는다.

형태소(morphemes, morphology)는 뜻을 가지는 가장 작은 단위다. 형태소를 모아야 단어를 만들수 있으며, 반대로 모든 단어는 하나 이상의 형태소를 모아 만들어졌다. 예로 음소라는 말은 소리를 나타내는 '음'과 가장 작은 단위를 나타내는 '소'가 결합되어 만들어졌다. 지금까지 단어가 형태소를 조합하여 만들어졌기 때문에 앞으로도 형태소를 조합하여 단어를 만들 수 있다. 2020년 초 신천지 교단에 의해 코로나19가 한국에 급속도로 전파되자 분노한 시민들은 신천지를 앞에 '역병','병신'처럼 질병과 관련된 형태소를 붙여 '역병천지','병신천지'라고 불렀다. 음소의 조합에도 규칙이 있듯이, 형태소의 조합에도 규칙이 있다.(morphological rule, 형태 규칙) 영어에서 er는 항상 단어의 끝에 와야하며, 반대로 re는 단어의 앞에 와야 한다.

형태소를 조합해 단어를 만들면, 이를 다시 조합해 구(phrase)와 문장(sentence)을 만들어야 한다. 통사론(syntax, syntactical rule)은 단어를 조합하여 구와 문장을 만드는 수준을 말한다. 단어를 조합해 문장을 만드는 규칙도 당연히 존재하며, 문법이라는 이름으로 우리에게 많이 알려졌다. 문법은 언어마다 다른데, 조사의 유무에 따라 모든 언어를 둘로 나눌수도 있다. 어떤 언어는 위에서 설명한 것처럼 단어를 조합해서 문장을 만들며, 모든 단어는 그에 맞는 위치에 들어가야 한다.

대표적으로 영어의 경우 주어의 역할을 하는 단어는 무조건 앞에 들어가야 하며, 서술어의 역할을 하는 단어는 중간에 있어야 한다. 이런 언어들(프랑스어,중국어)은 적절한 위치에 단어를 넣어야만 하며 단어의 위치에 따라 다양한 의미가 나타난다. 반면에 한국어는 모든 단어의 뒤에 조사가 들어가야 하는데, 이 조사가 단어의 성질을 결정한다. 예를 들어 한국어에서 주어는 뒤에 '은,는,이,가'가 들어가는 단어이고 동사는 '다'가 붙는 단어이다. 일본어, 핀란드어, 투르크어 등 이러한 언어들은 시시각각 변하는 조사들을 모두 외워야 한다는 끔찍한 점이 있지만, 위의 언어들과 달리 조사만 잘 지켜주면 위치선정에 자유로우며, 오히려 위치를 일부러 변형하여 문학적 효과를 노릴수 있다.(자네는 아는가? 그러한 느낌을)

음소들을 조합하여 수많은 형태소를 만들고, 또 이를 조합하여 무수한 단어, 문장을 만들어 냄으로써 인간의 언어는 무수한 의미를 창출할 수 있다. 거기다 recursion(recersive rule)까지 활용하면 실질적으로 무한한 의미를 언어를 통해 표현할 수 있다. recursion은 문법 규칙을 반복하는 것을 말하는 것으로, 다음의 예시는 '-와'로 끝나는 문법규칙을 반복(recursion)한 결과이다.

버즈는 달에 갔다.

버즈와 닐은 달에 갔다.

버즈와 닐과 마이클은 달에 갔다.

버즈와 닐과 마이클과 데이비드는 달에 갔다.

아래쪽 문장들은 단지 '와/과' 조사를 반복하여 닐과 마이클, 데이비드가 달에 갔다는 사실도 표현할 수 있게 만들었다. 비슷하게 영어에서는 what과 같은 관계대명사를 반복하여 새로운 의미를 문장에 끼워넣어 새로운 의미를 전달하는 문장을 만들수 있다. 이처럼 다양한 기제를 통해 인간의 언어는 한정된 음소 몇개로 거의 무한에 가까운 의미를 표현할 수 있다. 이러한 언어의 유연함은 인간이 서로 단순한 의미를 전달하는 것뿐만 아니라 서로 교역하고, 표현하고, 직접 눈으로 볼수 없는 추상적인 존재를 표현할수 있도록 만들었다.

인간의 언어능력

이처럼 놀랍도록 조직적이고 체계적인 언어를 만들어 사용한다는 점에서 인간의 언어능력이 매우 월등하다는 사실은 자연히 드러난다. 그래서 비록 연구를 수행하는 우리도 인간이지만, 언어심리학자들은 인간의 언어능력을 분석하고 밝혀내고자 노력해왔다. 학자들은 인간이 형태소를 특정 의미와 연결시키는 능력, 음소나 형태소를 결합하여 문법에 맞는 문장을 만드는 능력, 문장의 의미를 맥락에 따라 다르게 판단하는 능력을 밝혀내고자 했는데, 이러한 능력은 2010년대 말 구글 번역기를 비롯해 많은 인공지능에서 구현하고 있으나 인간 두뇌의 속도, 효율성에 비해 매우 초보적인 수준이다.

동물에 대한 연구도 인간의 언어 능력이 극히 뛰어남을 보여준다. 비록 언어사용의 유력한 후보인 돌고래가 제대로 조사되지 않았지만, 유인원에게 언어를 가르치려는 시도들은 인간의 언어가 얼마나 복잡하고 따라하기 어려운 능력인지 보여준다. 지금까지 학자들은 침팬지와 보노보에게 말, 수화, lexigram 등 다양한 수단을 통해 언어를 가르치려고 시도하였으나, 어떤 수단을 사용하든 유인원의 언어 수준은 인간보다 현저히 떨어졌고 기본적인 문법구조도 발견할 수 없었다. 특히 수화나 lexigram을 사용한 일부 사례는 조작이나 연구자의 부적절한 개입의 결과로 탄로되었다.

또한 인간은 언어를 제대로 구사하지 못하는 상황에서 언어를 새로 만드는 능력도 가지고 있다. 이러한 사실은 20세기 후반 니카라과의 농아학교에서 새로운 수화가 발견되면서 알려졌다. 당시 니카라과는 처음으로 농아를 가르치는 전문 교육기관을 설립했는데, 당시 니카라과는 공인 수화가 존재하지 않았기 때문에 학생들은 글을 통해 에스파냐어를 배워야 했다. 따라서 학생들은 에스파냐어(그것도 쓰는법만)만을 구사할 수 있었는데, 어느날 학교 관계자가 학생들을 관찰하다가 놀라온 사실을 발견했다. 수화를 배우지도 않았고 에스파냐어밖에 배우지 않았던 아이들이 스스로 손짓을 통해 의사소통을 하고 있었다는 것이다. 더구나 이 새로 생성된 수화는 시간이 지날수록, 어린 학생일수록 더 유창해지고 문법이 정교해지며, 즉 완전한 언어로 진화해가고 있었다. 이러한 언어의 생성과 진화는 중동의 베두인 마을에서도 발견되면서8 인간이 언어를 창조할 수 있는 능력이 있음이 널리 알려졌다.

이처럼 뛰어난 인간의 능력은 발달한 지능의 부산물이기 보다는 진화적 압력이 작용한 결과로 보인다. 사실 발달한 단일한 지능이 있다기보다는, 어떤 지적 작업에 특화된 여러 지능과 이들을 유연하게 이어주는 구조가 일반지능을 이룬다는 설명이 현실에 더 부합해 보인다. 언어지능은 중요한 지능의 구성요소이며, 시공간 지각을 포함하는 시공간지능과 구별되는 것으로 보인다. 또한 임상의들은 언어능력은 보전되지만 심각한 지능저하와 낮은 시공간 지각능력을 가진 윌리엄스 증후군(williams syndrome, genetic dysphasia, 부전실어증)을 발견했고, 지능과 다른 기능은 정상이지만 언어능력에서만 심각한 퇴보를 보이는 SLI(Specific Langauge Impairment)도 발견하였다. 이는 언어능력이 다른 지능과 구별되는 인지적, 생리적 기반을 가짐을 보여준다.

피진과 크리올

인간이 선천적인 언어구조를 가진다는 증거는 다른 곳에서도 찾아볼 수 있다. 그중 하나는 하와이이다. 하와이가 미국에 합병된 이후, 미국은 하와이에 플랜테이션 농장을 운영하기 위해 전세계에서 노동력을 수입했다. 이로인해 서로 말 한마디 안통하는 청나라인, 일본인, 조선인, 필리핀인, 포르투갈인, 푸에르토리코인이 영어를 쓰는 미국인의 지배아래 한곳에서 일하며 생활하게 되었다. 당연히 서로 의사소통하는 일은 매우 힘들었고 몸짓으로 대화해야 했다. 그런데 시간이 지나자 놀라운 일이 일어났는데, 시간이 좀 흐르자 이들이 서로 소통을 하기 시작했다. 그것도 특정 언어로 소통한 게 아니라 여러나라 언어가 섞인 이상한 언어로 서로 말했다. 그리고 더 시간이 지나 이들이 자손을 낳자, 자손들이 그 언어를 더 유창하고 정교하게 사용하였다. 이 사례는 피진과 크리올의 대표적인 사례이다.

피진(pidgin)은 2개 이상의 서로 다른 언어가 섞여서 탄생한 원시언어이다. 이 언어에서 문장은 보통 단순한 단어의 나열이며 주어나 목적어 외의 문법은 찾아보기 힘들다. 하와이에서 자생한 피진의 경우 영어를 중심으로 다른 언어의 어휘와 문법이 섞였으며, 모두 단일한 문법을 쓰는 대신 화자가 원래 사용하던 언어에 따라 다양한 문법이 사용되었다. 그래서 피진은 어눌하고, 비일관적이고, 유창하지 못하다. 그런 피진이 시간이 지나면서 안정적으로 변화하면 크리올이 되는데, 크리올(creole)은 피진이 고유한 문법과 어휘를 가진 단일한 언어로 진화한 것이다. 크리올은 피진을 사용하는 성인의 자손들이 피진을 습득하면서 자연적으로 발달하게 되며, 놀랍게도 저절로 단일한 문장순서와 시제표현, recursive rule이 생겨난다. 비슷한 사례로 수화를 잘 못하는 농인 부모 밑에서 태어난 농아가 유창하게 수화를 구사한 경우도 있는데, 이 사례들은 인간이 선천적으로 언어를 조직화하는 능력이 있음을 시사한다.

이중언어(bilingual)

이중언어자는 2개 이상의 언어를 사용할수 있는 사람들을 말한다. 많은 사람들은 이민이나 해외취업, 스펙, 다문화 가정 등의 요인으로 인해 자신의 모국어 이외에 다른 언어를 또 배우거나, 모국어가 2개이다. 전세계 인구의 절반이 약한 의미에서 이중언어자이며,9 사실 한국인들은 공교육을 통해 영어를 체계적으로 배우기 때문에 필자를 포함한 많은 한국인들도 이중언어자에 속한다.

과거에는 이중언어 교육이 정상적인 인지발달을 저해한다는 주장이 정설이었다. 실제로 의미 관련 언어유창성10은 이중언어자가 단일언어 구사자에 비해 낮다. 그러나 최근 연구는 양자 간에 실질적인 차이가 없으며,11 어떤 인지 기능에서는 단일언어 구사자보다 더 우세하다.12 또한 이중언어자는 좌측 두정엽 회백질이 훨씬 치밀하다.13 과거에 이중언어자가 인지발달이 늦다는 주장은 대개 이중언어자의 사회경제적 특성(가난한 이민가정)이 반영된 것으로 보인다.

두번째 언어를 배우는 것은 모국어를 배우는 것보다 더 힘든 일이다. 뇌영상 연구14에 따르면 갓 배우는 두번째 언어를 사용할때는 첫번째 언어에 비해 전두엽의 활동이 더 크다. 그러나 이러한 차이는 시간이 지날수록 감소하며, 차이의 크기는 두번째 언어에 익숙해지는 정도에 반비례한다. 이러한 경험은 뇌구조의 변화와 함께 나타난다.15

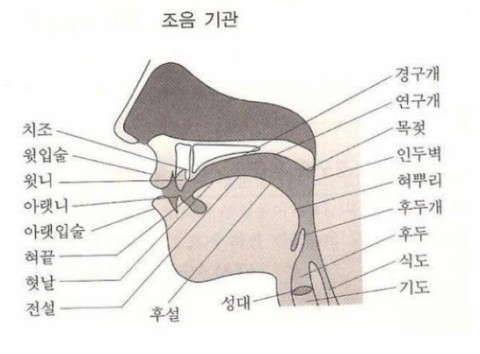

조음, 언어의 생성

영어를 기준으로 사람들을 말할때 초당 2개의 단어, 18개의 형태소를 사용한다고 한다. 이처럼 말을 기관총처럼 쏘아대기 위해서는 언어를 전문적으로 생산하는 기관을 갖출 필요가 있다. 인간의 경우 대개 입이 그 역할을 하며, 그래서 인간의 입과 혀는 다른 동물들과 구별되는 특징을 가진다. 인간의 언어는 뇌에서 시작해(linguistic level) 후두와 입을 거친 후(physiological level) 음파로 변형된다.(acoustic level) 이 과정은 사람이 소리를 들을 때는 역순을 거친다.

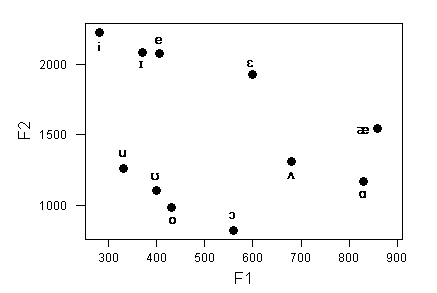

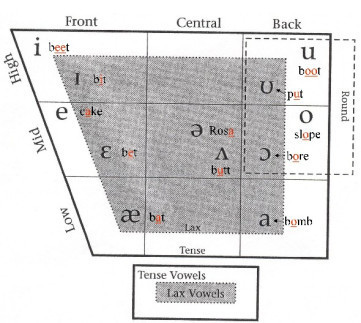

인간이 내는 음은 가장 크게 자음(consonant)과 모음(vowel)으로 나눌 수 있다. 모음은 방해받지 않은채 발성되는 음이다. 모든 음성은 성대에서 기도를 빠져나가는 날숨을 진동시켜 만드는데, 성대에서 생성된 음이 다른 방해과정을 거치지 않고 입과 코를 빠져나가면 이를 모음이라 부른다. 반대로 자음은 방해를 받으며 발성되는 음으로, 입술을 막거나 혀로 연구개를 자극하거나 해서 음이 나가는 통로에 이상이 생길때 나타나는 음이다. 하지만 모음도 완전히 영향을 받지 않는건 아니라서, 혀의 위치를 통해 여러 개의 모음을 낼 수 있다. 모음은 포먼트(formant)라는 요소로 구성되는데, 포먼트는 인간의 성대가 낼 수 있는 주파수의 상음(overtone) 특성을 말하는 것으로 총 3가지(F1,F2,F3)가 있다. 이 포먼트의 높낮이를 혀를 통해 전환시키는 것으로 각기 다른 모음을 발성할 수 있다.

모음은 4가지 차원을 어떻게 조절하느냐에 따라 각기 다른 소리가 난다. 이 4가지 차원은 tongue height, frontness/backness of tongue, tenseness, lip rounding이 있는데, tongue height는 말 그대로 혀의 높이를 의미한다. 혀의 높낮이에 따라 다른 모음이 날 수 있으며, 예를 들어 i와 a는 같은 자리에서 혀높이만 다른 음이다. 위 표에서 세로축이 tongue height를 나타낸다. tongue position는 혀의 전진 정도를 의미한다. 혀가 앞쪽으로 나오나 뒤쪽으로 나오나도 조음에 중요한 영향을 끼친다. 가령 i와 u는 tongue height는 같지만 u는 혀가 안쪽으로 나온데 반해 i는 바깥쪽으로 나와있다. 위 표에서의 가로축이 이를 나타낸다. tenseness는 발음위치와 혀의 중심간의 거리로, 빗에서의 i가 허니문에서의 i보다 혀의 중심에 가까워서 구별된다. 위 표에서 짙게 칠해진 부분이 lax한(가까운) 발음위치를 나타낸다. 마지막으로 roundness는 발음할때 입술의 모양으로, 입술을 둥글게 오므리면 다른 소리가 난다. o나 u와 같은 경우가 roundness가 강한 경우이며 발음위치는 기도쪽이다. 위 표에서 목구멍쪽에 그려진 사각형 안이 roundness가 강한 발음위치다. 위와 같은 4가지 차원이 각기 다른 모음을 만들며, 이중 tongue height와 tongue position이 각각 F1, F2를 조절한다.(위쪽으로, 앞쪽으로 갈수록 높아진다)

모음이 4가지 차원과 3가지 포먼트의 조합으로 나타나듯 자음도 3가지 차원으로 나눌 수 있다. glottis는 발음이 나타날때 후두의 상태로, 발음할때 후두가 터져나오듯이 단기간에 진동하고 끝나는지, 아니면 좀 더 오래 진동하는지의 차이를 말한다. 파열음은 터져나오듯 나오는 자음으로 voisless라 부르며, b,d,g와 같은 음들은 진동하듯이 나오기 때문에 voiced하다고 부른다. place of articulation은 자음이 발음되는 위치로, 음을 해당 자음이 되게 만드는 위치이다. p는 입술에 압력을 주었다가 터지듯이 열면서 만들어지는데, p의 place는 입술이다. 한국어 음소에서 자음의 생성 위치는 아래 그림과 같다.

마지막으로 manner of articulation은 그 음이 흘러나오는 방식으로, 소리가 나오는 방식을 말한다. manner는 총 아래 6가지 방식이 있다.

- stop: 소리가 완전히 막혔다가 나온다. b처럼 입술을 막았다 나오는 소리가 여기 해당한다.

- fricative: 완전히는 아니고 소리가 부분적으로 막혔다 나온다. 이 경우 부분적으로 빠져나온 소리에 의해 난류가 형성된다. s나 f가 여기 해당한다.

- affricate: 소리가 일시적으로 막혔다가 나오는 경우다. k는 연구개를 일시적으로 패쇄했다가 나오는 과정에서 생겨나는데 이것이 대표적이다.

- nasal: 비강을 통해 소리가 난다. 어차피 음성은 기도에서 시작되기 때문에 이게 코로도 갈 수 있다. m, n처럼 발음할때 코가 울리는 자음이 nasal이다.

- 유음(liquid): 모음과 같이 순수한 음성에서 출발하지만 중간에 혀에 의해 왜곡을 받는다. 그러나 그 정도가 다른 자음보다 약하다. ㄹ가 대표적이다.

- glide: 이 경우는 모음과 상당히 비슷하여 필자는 예전에 glide를 모음이라 여긴적이 있었다. 발음될때 여러 모음위치에서 동시에 발음된다. w가 대표적이다.

음소지각(speech perception)

인간은 여러 단어와 문장을 묶어 담화를 만들고 서로 대화한다. 인터넷이 발달하면서 이러한 소통이 글로 이뤄지는 경우도 많아졌지만 아직도 많은 대화는 복잡하게 조직된 음소로 이루어진다. 이런 일은 사실 조금 생각해보면 매우 어렵고 복잡한 일이다. 왜냐하면 문어와 달리 구어는 음소와 음소 사이에 명확한 간격이 없고(segmentation problem), 각 음소가 앞뒤에 배치된 음소에 영향을 받아 변하기 때문에(co-articulation) 실제로 쓰이는 음소와 적히는 음소가 많은 차이를 보기 때문이다. 이외에도 말하는 스타일, 강도, 성조, 사투리 등 무수한 요인들이 구어에 영향을 줘 사람들이 구어를 동일하게 인식하는 것을 방해한다.(lack of invariance)

인간은 이러한 어려움을 어떻게 극복할까? 범주지각(categorical perception)은 하나의 해답이 될 수 있다. 범주지각은 인간이 음파를 몇개의 음소로 나누어 해석하는 것을 말하는데, 즉 인간은 때마다 다른 음파를 몇개의 음소로 범주화시킨다. 예를 들어 b와 p의 경우 발음구조는 비슷하지만 VOT에서 차이가 나기 때문에 다른 음으로 지각된다. VOT(Voice onset Time, 음성 개시 시간)는 입에서 발화하기 시작한 음이 성대에 도달하기까지 걸리는 시간으로, b가 p보다 긴 VOT를 갖기 때문에 두 음이 차이가 난다. 이러한 구조를 이용하면 b와 p의 중간에 해당하는 음을 10개정도 만들수 있는데, 학자들은 이를 이용하여 b와 p 사이의 중간음을 만들고 사람들이 어떻게 지각하는지 관찰하였다.16 그러자 사람들은 모든 음으로 b나 p라고 들었으며, b와 p의 정 중간지점을 중심으로 VOT가 짧아질수록 사람들이 음을 p라고 인지했다. 이는 사람이 음소를 그대로 듣는 것이 아니라 특정 기준을 가지고 음을 특정 음소로 분류한다는 것으로 보여준다.

또한 사람들은 말을 들을때 귀만 사용하지는 않는다. 인간은 음소를 지각할 때 다양한 양식(intermodal)의 감각을 사용하며, 특히 눈을 사용한다. 실제로 어떤 음소는 눈을 가리면 지각하거나 구분하는게 매우 힘들어진다. 실제로 실험에서 연구자는 자신이 '다'를 발음하는 영상을 찍은 후 피험자에게 이를 보여줬는데, 영상을 본 피험자는 음을 '다'라고 들었지만 음성만 들은 피험자는 음을 '바'라고 들었다. 이는 실제 음은 바에 가까웠지만 전자의 경우 입을 벌려 발음하는 연구자의 입을 직접 보았기 때문이다. 비슷한 실험을 BBC에서도 보여줬었는데#(0:30부터), 실험에서 보는바와 같이 실제로 음은 달라지지 않았지만 사람들은 앞의 것을 b, 뒤의 것을 f라고 생각했다. 이는 발음하는 입모양이 바뀌었기 때문이다. Mcgurk effect17도 비슷한 현상으로, 이 현상은 사람이 '바'음성과 '가'를 발음하는 입을 보면 마치 '다'를 들은 것처럼 인식하는 현상이다. 이처럼 사람들은 소리를 어떻게 내는지에 대한 기본적인 지식(knowledge of articulation)을 가지고 있고 이 지식을 기반으로 다양한 채널의 정보를 통합적으로 처리하기 때문에 비록 실제 음은 구분하기 힘들지라도 다른 음소로 구별해내는게 가능하다.

이 분야의 주요 연구자로는 kuhl이 있다. 그는 범주지각을 연구했다.

음소지각의 기원(origin of speech perception)

이러한 능력은 타고나는가? 아니면 학습의 산물인가? eimas와 동료들18은 일찍이 이를 알아보기 위해 실험을 했는데, 그는 유아들을 대상으로 HAS 절차를 사용하여 이를 연구하였다. HAS 절차(High Amplitude Sucking procedure)는 말을 하지 못하는 아동을 대상으로 발달심리학에서 사용하는 기법으로, 아기들이 관심있는 것을 볼때는 젖꼭지를 빠는 횟수가 빨라지지만 반대로 지루하거나 졸릴때는 줄어드는 것을 활용하는 기법이다. 이 기법을 사용하는 연구자들은 보통 두개의 자극을 아기들이 변별할 수 있는지 연구하는데, 하나의 자극을 습관화시킨 후 다른 자극을 제시하여 젖꼭지를 빠는 횟수가 빨라지는지를 관찰하여 아기가 자극을 새로운 것으로 인식하는지 확인한다. eimas와 연구자들은 범주지각을 연구할때 사용하던 음들을 아기한테 들려주었는데, '가'음에 습관화된 아기들은 '가'음과 가까운 중간음에는 반응하지 않았지만 '카'음과 가까운 중간음을 들려주자 젖꼭지를 빠는 횟수가 증가하였다. 이 아기들은 무언가를 학습하기에는 너무 어린 연령이었기 때문에 이는 인간의 범주지각이 본성이라는 증거가 된다.

한편 kuhl과 밀러(miller)19는 인간의 범주지각을 연구하면서 동물의 범주지각도 함께 연구하였다. 이들이 연구한 대상은 포유강 설치류에 속하는 친칠라였는데, 친칠라는 말을 못하기 때문에 이들 연구자들도 eimas처럼 별다른 방법을 고안해야 했다. 이들은 친칠라에게 '가'음이 나올때는 가만두고 '카'음이 나올때 전기충격을 가해 친칠라가 '카'음이 나오면 도망가는 반응을 학습시켰는데, 이러한 기법을 ACP(Avoidance Conditioning Procedure)라 한다. 연구자들은 이 기법을 사용해 친칠라를 훈련시키고 역시 중간음들을 제시한 다음 이에 대한 반응을 인간과 비교했는데, 친칠라의 반응은 인간과 같았다. 즉 범주지각을 통한 음소변별 능력은 인류 이전부터 존재하던 본성으로 보인다.

범주지각이 선천적으로 타고나는 능력이라면 intermodal한 음소처리 능력도 선천적일까? 아마 그럴 것이다.20 이를 위해 시행한 한 연구는 4달 반된 아기를 대상으로 실험을 진행하였다. 연구자들은 intermodal한 정보처리의 대표적인 예시인 Mcgurk effect를 이용하였는데, 아기들을 두 집단으로 나눠 실험군에는 '바'음성과 '가'를 발음하는 입을 보여주고 대조군에는 '바'음성과 '바'를 발음하는 입을 보여주었다. 그리고 아기가 충분히 습관화가 되면 연구자들은 아기들에게 '바'와 '다'음을 들려주고 아기가 소리가 나오는 화면을 쳐다보는 시간을 측정하였는데, 실험결과 실험군의 아기들은 '다'음에는 습관화된 반면 '바'음에는 반응하였다. 이는 아기들에게도 Mcgurk effect가 나타났음을 보여주며, intermodal한 음소처리 역시 선천적인 능력임을 시사한다.

언어능력은 어디에서 왔는가(theories of speech perception)

인간의 독특한 음소지각과 언어구성 능력은 어디에서 왔는가? 그 기능적, 진화적 기원에 대해서는 서로 다른 두 이론이 대립하고 있다. motor theory는 언어지각(speech percpetion)이 인간이 타고나는 능력, knowledge of articulation처럼 인간이 선천적으로 타고나는 특수한 능력을 통해서 가능하다고 한다. 이 이론에 따르면 인간은 종의 필요성에 의해 언어만을 위한 특수한 기능들을 진화시켜 왔으며, 의미를 생산하는 능력이 바탕을 이룬다고 본다. 이러한 능력은 앞서 말했듯이 본능으로서 유전자에 내재되어 있다. 반면 auditory theory는 인간의 언어지각은 단지 말소리의 정교한 청각적 특징을 잡아내는 청각 능력에 의해 가능하다고 본다. 이 이론은 인간의 언어지각이 그저 다른 동물에 비해 조금 더 발전한 청각 능력에 의해 가능하며, 생물학적인 청각 시스템이 그 기반을 이룬다고 주장한다. 그렇기 때문에 이러한 언어지각 능력이 본능인지 학습의 결과인지는 이 이론에서 별 관심이 없다. 더 잘 듣는 능력은 타고날수도, 배울수도 있기 때문이다.

현재까지의 증거들은 motor theory를 지지한다. 실제로 knowledge of articulation처럼 본능에 내재되어 언어생산에 관여하는 특수한 기능이 존재한다. 또한 비록 범주지각이 다른 포유류에서도 관찰되지만21 일부 친칠라는 학습에 최대 3달이 걸렸으며 이외에 r/L을 구분하거나 서로 다른 모음을 구분하는 능력은 영장류에서 관찰되지 못했다. 반면 인간 영아는 이를 비교적 쉽게 하며, 음을 단순히 주파수를 기준으로 한 거리가 아니라 여러 음운적 특징으로 변별한다. 즉 언어지각은 본능으로 보이며 인간에게서만 나타나는 여러 기능을 포함하는 듯이 보인다. 아직 완전한 결론을 내리기에는 데이터가 부족하지만 적어도 현 시점에서 motor theory는 auditory theory보다 합리적으로 보인다.

언어의 발달

인간의 언어능력은 많은 부분 선천적이지만 그렇지 않은 부분도 많다. 인간은 누구나 음소를 변별하는 능력을 타고나지만, 그들이 자라면 사용하는 언어에 따라 음소를 달리 구분하게 된다. 가령 영어 사용자는 30ms를 기준으로 vot가 그보다 길면 ㅌ, 짧으면 ㄷ라고 구분한다. 그러나 프랑스어나 에스파냐어에서 그 기준은 0ms다. 이는 네덜란드어도 마찬가지며, 반면에 독일어와 중국어는 영어와 비슷하게 ㄷ/ㅌ를 구분한다. 그러나 이 둘의 차이는 다른 언어와 비교하면 사소한 차이에 불과한데, 일부 언어는 음소를 vot에 따라 3개로 구분한다. 태국어는 -20ms와 40ms를 기준으로 하여 음소를 3가지로 나눈다. 한국어는 더 괴상한데, 0ms와 20-30ms로 구분한다. 그것도 0ms 이하는 된소리로, 20-30ms 이상은 거센소리로, 그 중간은 예사소리로 구분한다. 즉 앞에서 언급한 언어들에서 모두 ㅌ라고 인식하는 음 중 하나는 한국어에서는 ㄷ로 인식된다. 한국어로 ㄱ발음인 자음이 k로 번역되거나, 외국어 표기를 거센소리로 해야하는지 된소리로 해야하는지에 대한 끊임없는 논쟁은 일정부분 이러한 구조에 원인이 있다. 종합적으로, 인간이 태어난 환경은 기본적인 음소변별을 비롯하여 언어능력의 발달에 영향을 끼친다.

그렇다면 언어능력은 어떻게 발달해 가는가? 이에 대해 3가지의 관점이 존재한다. universal theory(nativist theory)는 모든 언어능력이 선천적으로 타고나는 것이며 학습은 단지 그것을 유지시키는 것이라고 주장한다. 이 이론에 따르면 인간이 가지고 태어나는 언어능력 중 잘 쓰이는 것(한국어에서 된소리를 구분하는 것)은 그대로 유지되지만, 학습을 통해 보충되지 않는 것(한국어에서 r을 l과 구분하는 것)은 퇴화하여 사라진다. 이와 반대로 learning theory(perceptual learning theory)는 모든 언어능력이 후천적으로 학습하는 것이라고 주장한다. 이 이론에 따르면 갓 태어난 아기는 백지 상태이며 아기가 태어난 사회에서 배운 언어만을 습득하게 된다. 이 이론은 그다지 지지를 받지 못하고 있다. attunement theory(perceptual attunedment theory)는 이의 절충형으로, 인간이 기본적으로 언어능력을 가지고 태어나는데 이것이 학습을 통해 더 발달할 수도 있고 학습을 받지 못해 퇴화할 수도 있다.

언어능력이 어떻게 발달하든, 학자들은 언어발달에 결정적인 시기가 있음에는 동의하고 있다. 즉 언어를 매우 빠르고 잘 배우는 특정 시기가 있으며, 이 시기가 지나면 언어를 배우기 힘들다. 이는 부모의 학대로 인해 결정적 시기에 언어를 배우지 못한 아이의 사례에서 처음 확인되었으며,22 이민자 아동 연구23나 fMRI 연구24에서도 관찰되었다.

단어지각

위에서 우리는 음소가 어떻게 연속적인 음파에서 따로 떨어져 지각되는지 보았다. 아마 단어를 지각하는 원리도 음소를 지각하는 원리와 대동소이할지 모른다. 그러나 단순히 음소지각의 원리를 외삽하기에는 우리가 고려해야 할 것이 몇가지 있다. 먼저 단어지각도 연속적인 음파에서 단어를 식별해야 하는 어려움이 있다. 이는 얼핏보면 음소지각과 같아보인다. 그러나 단어는 범주를 통해 지각할 수 없다. 음소는 vot를 통해 변별할 수 있지만 단어는 여러개의 음소가 합쳐져 나타나기 때문에 더 많은 변수를 고려해야 한다. 이는 단어 사이의 간격이 파형 사이의 간격이 아니기 때문에 더 문제된다.

또한 음소에 대한 지식은 어느정도 선천적으로 내재된 반면 단어는 문화마다 다르다. 즉 단어는 순전히 문화적인 현상으로, 아기는 무조건 외부의 단어를 배워야 하는데 그것도 대부분의 경우 대상이 제시되면서 배우기보다는 단어 하나만 제시된다.아기들이 엄마라는 표현은 자신을 가리키며 '엄마'라고 말하는 어머니들을 통해 쉽게 배울수 있지만, 엄마가 쓰는 분유라는 단어는 대체로 분유와 함께 제시되기보다는 '분유' 단어 자체만 제시된다. 또한 띄어쓰기 하나를 빼고 완전히 같은 단어(icecream은 I scream과 비슷하다)도 있다. 이러한 어려움을 뚫고 인간은 어떻게 단어를 배워서 필자처럼 유창하게 구사할까?

첫번째 답은 음소지각과 비슷하다. 운율(prosody)은 단어를 지각하는데 도움이 된다. 서울사람들은 대개 말끝이 올라가면 이것이 의문문이라는 사실을 매우 빠르고 무의식적으로 인지한다. 또한 영단어에는 아직 강세가 남아있어서, 영어 사용자들은 말의 강세 변화를 보고도 앞으로 나올 단어를 예측할 수 있다. 이러한 운율은 단어를 지각하고 문장을 이해하는데도 필수적이다. 이러한 운율에 대한 규칙은 아기들도 아는 것처럼 보이는데, 7개월된 아기는 똑같이 낮선 지문을 하나는 문법적으로 맞게, 다른 하나는 문법적으로 틀리게 띄어쓰기 된 버전으로 낭독되었다. 그러자 아기는 문법적으로 맞는 지문을 덜 오래 쳐다보았다. 이는 7개월된 아기가 문장의 운율을 어떻게 맞추는지에 대한 지식을 가지고 있음을 보여준다. 비슷한 사례가 강세(stress) 지각에 적용되는데, 많은 언어들은 독특한 강세를 가진다. 영어에서 apple은 a를 높은 음에서 시작하여 내려가는데 반해, 한국어의 사과는 강세의 변화없이 단조롭다. 한편 일본어의 リンゴ는 앞부분의 りン자를 약간 올려서 단어를 시작한다. 이러한 강세가 단어지각에 상당히 중요할 수 있는데, 실제로 아래 distributional regularity를 입증한 연구의 후속 연구25에서는 가짜단어의 강세를 사용된 단어와 비슷하게 한 뒤 아기들에게 제시했는데, 아기들은 가짜단어를 이미 들었던 단어로 해석하였다. 그러나 이 결과에 대해서는 논쟁이 있다.

다른 대답은 distributional regularity(transitional regularity)라고 불린다. distributional regularity는 단어가 특정 음소의 집합이라는 사실에 주목하게 한다. '단어'라는 단어는 ㄷ,ㅓ,ㄴ,ㅇ가 서로 결합된 결과이며, 따라서 어떤 음소집합이 반복적으로 나타난다면 이것은 단어가 틀림없다. 이러한 가정 하에서 인간은 두 음소가 확률적으로 얼마나 결합하는지를 보고 결합 확률이 1에 가까울수록 해당 집합을 단어로 여기게 된다. 어떤 연구자는 이 실험을 8개월된 아기들에게 실시했는데, 연구자들은 '골라부'나 '파비쿠'와 같은 이상한 단어를 인공적으로 만들고 아기들에게 연속해서 들려줬다. 그 뒤 아기들에게 실제 사용된 인공단어와, '부파비'나 '라부파'처럼 연속해서 들린 음으로 만든 가짜단어를 들려주고 아기들이 어떤 소리를 더 오래 듣는지 관찰하였다. 그 결과 아기들은 가짜단어를 지금까지 듣지 못한 단어로 지각하고 더 오래 들었다.

이전 문단 내용을 기억하는가? 분명 형태소의 형성은 각 언어마다 다른 특정한 규칙에 의해 제한된다고 했다. 이러한 typical shape word(phonotactic constraints)도 단어지각에 중요한 기여를 한다. 다시 말하지만 각 언어는 음소를 결합해서 형태소를 만드는데 일정한 규칙이 있다. 예를 들어 영어에서 dstr가 한데 붙어 나오는 일은 있어서는 안된다. 그래서 hamstring은 있지만 hadstring은 성씨를 빼면 없다. 반면 kt는 같이 붙을 수 있지만 이탈리아어에서는 안된다. 한국어도 지난 19세기에는 '프랑스'나 '아메리카'와 같은 조합은 인정되지 않았기 때문에 대신 '불란서'와 '미리견'이라는 단어를 사용했다.

이러한 규칙은 앞으로 단어를 배우는데도 도움이 되는데, 특히 연속적인 말 속에서 없는 단어를 추출하는 일을 없게 만들어 준다. 한 실험에서 연구자는 18개월 아기들에게 특정 도형의 이름을 형태소 규칙에 맞거나 틀린 인공단어로 붙여주고, 그 뒤 아기들에게 두 도형을 제시한 후 단어가 가리키는 도형을 보도록 지시했다. 실험결과 아기들은 형태소 규칙에 맞는 이름을 가진 도형을 더 오래 보았으며, 이런 효과는 이미 단어를 많이 아는 아기들일수록 두드러졌다.

마지막으로 동시조음(co-articulation)도 해결책이 될 수 있다. 동시조음은 언어를 발화할때 일어나는 현상인데, 사실 음소지각을 어렵게 만드는 현상이기도 하다. 사람이 음소를 발화할때 음소는 서로의 포먼트에 영향을 끼쳐 실제로 발음되는 음을 약간씩 다르게 만든다. 이런 현상은 사람이 음소를 제대로 지각하는 것을 방해한다. 그러나 음소지각을 방해하는 동시조음은 단어지각에는 오히려 도움이 된다. 왜냐하면 동시조음은 기본적으로 한 단어 안에서만 일어나기 때문이다. 즉 동시조음이 일어나는 음성 단위를 한 단어로 지각하면 단어를 쉽게 지각할 수 있다. 실제로 상술한 연구26에서는 가짜단어를 중심으로 동시조음이 일어나게 한 후 아기들에게 인공단어와 가짜단어를 제시하자 아기들이 가짜단어를 단어로 인식하였다.

단어인지

위에서 보았듯이 다양한 단서를 통해 인간은 단어를 변별할 수 있다. 그러나 다른 문제가 남는다. 단어를 알았다고 치자, 그게 무슨 뜻인지 어떻게 알 수 있는가? 인간은 태어나서 처음 들은 단어가 뜻이 무엇인지 어떻게 알 수 있을까? 이에 대한 전통적인 해답은 철학자 로크가 제시한 연합(association)이었다. 로크는 부모들이 아기에게 대상을 보여주고 대상을 지칭하는 단어를 반복해서 말함으로서 단어와 대상이 연합되어 학습이 일어난다고 주장했다. 그러나 이 주장은 언어철학이 정립된 이후 많은 비판을 받았다.

대표적인 비판 중 하나로 철학자 콰인은 엄밀히 말해서 그러한 연합은 불가능하다고 했다. 예로 부모가 사과를 들고 아기에게 '사과'라는 단어를 알려준다고 하자. 그렇다면 '사과'라는 단어는 부모가 손에 들고 있는 빨간 공을 의미하는 걸까? 아니면 공을 든 손을 의미하는 걸까" 빨간 공에 달린 꼭지를 의미하는 건가? 혹시 무언가를 집어드는 것을 의미하는 것이 아닐까? 반증이 이론을 반증하는지 개별 가설을 반증하는지 모르기 때문에 이론의 반증이 불가능하다고 주장했던 콰인은, 그러한 논의를 여기서도 들고 와 단어가 지칭하는 대상이 어떤 것인지 알 방법이 없다고 지적했다.(problem of induction)

또한 발달심리학자들은 연합에 의한 단어학습이 실제와 잘 맞지 않다고 지적했다. 연합론자들에 따르면 단어는 일일이 대상과 단어를 연합시켜야 배울수 있으며, 그래서 어휘를 배우는게 매우 느리다. 그러나 실제로 아기들은 2-3살때 단어를 폭발적으로 배우기 시작하며(vocabulary spurt, word explosion), 3살때는 거의 하루에 8개의 단어를 배운다. 이는 더 가속화되서, 3살때까지 인간은 평균 1200-2000개의 단어를 배우지만 6살때는 14000개, 고등학교 졸업자는 45000개를 학습한다. 이는 연합주의자의 가정에 비해 너무 빠르다. 이외에도 어떤 단어들은 같은 상황에서 항상 동시에 나타나기 때문에('주다'와 '받다'는 같은 상황에서 나타난다) 이 둘을 연합으로 변별할 수 없으며, 추상적인 단어이거나 지금 당장 보여줄수 없는 단어는 연합으로 배울수 없다.

연합으로 단어를 배울수 없다는 사실이 명백하지만, 연합을 통해서만 단어를 배울수 있다. 왜냐하면 단어는 외부에서 학습하는 것이기 때문이다. 그렇다면 어떻게 사람은 연합을 통해서 단어를 배울까? 언어학자들은 사람이 단어를 연합시키는 특정한 규칙이 있을 것이라고 가정한다. 즉 콰인의 주장과 달리 사람은 특정 대상만 단어와 연관시키는 경향(bias)이 있을 것이며, 이 특별한 규칙에 의해 단어의 뜻을 배우는게 가능할 것이다.

실제로 markman들은 그러한 규칙(이를 taxonomic이라 한다)으로 몇가지를 제시했는데, whole-object assumption은 단어가 어느 특성이 아니라 물체를 지칭한다는 가정이다. 즉 위의 예에서 '사과'가 가리키는 것은 손이나 사과같은 물체가 되어야지, 꼭지나 손가락처럼 물체의 일부가 될 수 없다는 말이다. 그리고 같이 제시된 mutual exclusivity assumption(mutual exclusivity)은 모든 대상이 단지 하나의 이름만을 가진다는 가정이다. 즉 만약 아기가 '손'이라는 단어를 알고 있다면, '사과'는 손이 될 수 없다. 왜냐하면 손은 이미 이름이 있기 때문이다. 이런 규칙들은 단어가 의미할 대상들의 후보군을 좁혀서 대상을 쉽게 찾을수 있게 도와준다.

또한 이미 제시된 규칙도 단어인지에 기여하는지 모른다. 새로운 단어를 배우는 일은 필자도 하는 일인데, 필자는 새로운 단어를 보면 이것이 문장 속에서 어떤 구조로 쓰이는지 파악한다. 즉 문법규칙 속에서 그 단어가 어떻게 사용되는지를 파악하여 단어의 뜻을 유추하는 것이다. yuan과 fisher의 연구27에서는 아기들에게 대화문을 들려줬는데 대화문은 누군가가 다른 누군가에게 'blicking'을 했다는 내용을 담고 있었다. 대화문을 들려준 후 연구자들은 아기에게 한 사람이 다른 사람에게 무언가를 하고있는 사진과, 한 사람은 가만히 있고 다른 한 사람은 무언가를 하고 있는 사진을 보여준 후 blicking하고 있는 사진을 보게 했다. 그 결과 아기들은 전자의 사진을 보았다. 즉 아기들은 문법적인 규칙을 이용해 단어가 지칭하는 바를 유추해냈다.

Mutual Exclusivity의 한계:이중언어자의 경우

mutual exclusivity는 단어를 배우는 중요한 도구 중 하나지만, 어떤 상황에서 mutual exclusivity는 오히려 단어학습을 방해할 수 있다. 그 중 하나는 이중언어자(bilingual)의 경우이다. 이중언어자는 2개의 언어를 구사할 수 있는 사람인데, 이 말은 이중언어자가 한 대상을 지칭하는 두개의 단어를 알아야 한다는 것이다. 예로 한국어와 영어를 구사할 수 있는 사람은 사과가 '사과'와 'apple'이라는 두개의 이름을 가진다는 점을 알아야 한다. 많은 어린이들은, 특히 부모가 서로 다른 언어를 사용하는 경우 굳이 다른 언어를 배우지 않아도 자연스레 이중언어자로 자라나게 되는데, 이것은 mutual exclusivity에 위배되는 일이다. 왜냐하면 아이들이 mutual exclusivity를 엄격하게 지킬 경우, 한쪽 언어에서의 단어는 절대 배울수 없기 때문이다. 그렇기 때문에 학자들은 이중언어자의 경우 mutual exclusivity의 사용을 억제한다고 가정해 왔으며 실제 결과도 그러했다.

werker와 byers-heinlain28도 연구를 통해 그럴 가능성을 조사하였다. 이들은 캐나다의 브리티시 컬럼비아에서 표본을 모집했는데, 다행히도 브리티시 컬럼비아는 수많은 인종이 모여사는 다문화사회라서 이중언어자는 물론 3개의 언어까지 사용하는 삼중언어자(trilingual)까지 모집할 수 있었다. 연구자들은 그러한 배경의 아이들을 모집하고 먼저 이들이 아는 어휘와 구사할 수 있는 어휘의 수를 파악한 후, 두 조건에서 아기들을 실험하였다. 첫번째 조건(familiar label)에서 연구자들은 아이들에게 자동차와 공을 보여준 후 자동차를 보라고 지시하였다. 그리고 아이들이 어딜 보는지 아이트래커로 기록하였다. 두번째 조건(novel label)도 비슷했지만 두번째 조건에서는 신발과 광전관(아마 이것이 뭔지 잘 모를 것이다. 그래서 이걸 골랐다)을 보여준 후 'nil'을 보라고 지시하였다. 이미 아이들은 신발(shoe)이란 단어를 알고 있기 때문에 mutual exclusivity를 사용한다면 아이들은 광전관을 바라봐야 한다. 연구자들은 novel label 조건에서 이중언어자와 단일언어자(monolingual)의 차이가 있는지 검증하였다.

실험결과는 가설을 지지했다. 통제군 역할을 했던 familiar label 조건에서는 집단간에 차이가 없었지만 novel label 조건에서는 그렇지 않았다. trilingual은 nil을 보라고 했을때 광전관을 보는 경우가 기준선과 유의미한 차이가 없었으며, 이중언어자의 경우에도 p가 매우 높았다.(p=.057) 반면 단일언어자의 경우에는 nil을 쳐다보는 시간이 유의미하게 높았다.(d=.66, p<.0095) 아이가 구사할 수 있는 언어의 수는 광전관을 바라보는 결과와 부적으로 상관되어 있었다.(β=-.317) 결론적으로 구사하는 언어가 늘어날수록 mutual exclusivity를 사용할 확률이 적었다.

사회적 단서(social cue)의 역할

문법 규칙을 활용하는 것은 특히 동사의 의미를 파악하는데 좋다. 하지만 더 어린 아기들, 즉 문법 규칙을 아직 습득하지 못한 아기들은 쓸수 없는 방법이다. 대신 이런 아기들은 언어능력보다 더 빨리 발달하는 사회적 능력을 이용할 수 있을 것이다. 즉 어른이 보여주는 social cue를 사용한 단어학습이 가능할 수 있다. 만약 아기가 자신에게 단어를 가르치는 어른의 시선을 따라갈 수 있다면 단어가 지칭하는 대상을 좀 더 빨리 파악할 수 있을 것이다. 실제로 볼드윈이 진행한 실험에서 아기들은 어른이 대상을 눈으로 가리키면서 'toma'라고 지칭한 경우에만 대상을 toma라고 불렀다. 이처럼 어른과 아기의 시선이 어떤 대상에서 일치하는 경우(joint reference) 이를 이용하여 단어를 배울 수 있다.

또한 verhagen과 동료들의 연구에서 아기들은 연구자가 이미 아는 단어와 social cue가 충돌하는 상황을 만들었는데 이 연구에서 연구자는 아기들에게 자동차 옆의 이상한 물체를 가리키며 '차를 가져다줘'라고 부탁했다. 이 연구에서 아이들은 이미 '자동차'라는 단어를 알고 있음에도 이상한 물체를 골랐으며 이는 아기에게 익숙하지 않은 언어로 질문이 제시되거나 아기가 이중언어자일때 더 심했다. 이는 다른 제약이 잘 통하지 않을때 아기들이 사회적 신호를 잘 이용한다는 점을 보여준다. 특히 자폐아의 경우 변함없이 mutual exclusivity를 사용했다는 점이 이를 지지한다.

단어학습과 교육

단어학습은 앞으로의 발달에 중요하다. 무엇보다 단어는 새로운 것을 배우는데 필수적이며, 특히 고차원적이고 전문적인 것일수록 더 고차원적이고 전문적인 개념을 알아야 하는데, 이를 알려면 고차원적이고 전문적인 단어를 알아야 한다. 단어에 대한 지식은 지능의 구성요소중 하나인 언어이해능력을 뒷받침하는 주요 요소이며 실제로 학업 성적을 예측한다. 이러한 단어학습에는 여러 요인들이 영향을 미치지만, 주로 부모의 SES가 단어학습의 속도와 처리효율에 중요하다.

SES는 배운 어휘의 양과 단어관련 과제에서의 처리효율을 예측하는 주요 요인이다. 실제로 전문적인 부모(SES가 높은 부모) 밑에서 자란 4살 아이는 평균 4500만개의 어휘를 구사하지만, 가난한 부모 밑에서 자란 경우에는 1300만개에 불과하다. 즉 단어 3200만개 분량의 지적 능력의 차이는 단순히 어떤 부모 밑에서 태어났느냐에 의해 결정된다. 이에 학자들은 정확히 SES가 어떻게 단어학습에 영향을 미치는지 조사하였는데, 그 결과 어머니의 학습(maternal education)이 가장 중요한 요인임을 발견하였다. 연구자들이 조사한 바에 따르면 중산층/상류층의 어머니들은 아이들에게 단어를 가르칠때 더 다양한 단어들을 더 많이 가르치고, 아이들이 좋아하는 주제로 대화하면서 가르치며, 아이에게 직접 지시하는 일은 최대한 자제한다. 이러한 교육방식은 아이가 흥미를 가지고 더 많은 단어를 배울수 있게 만들며, 이로인해 아이의 어휘능력이 발전하면 부모는 이에 자극받아 더 질좋은 교육을 제공한다. 반대로 좋지 않은 교육으로 인해 아이의 어휘능력이 늦게 발달할 경우 피드백은 반대로 작용하는데, 이것이 하류층 아이들의 어휘능력이 상대적으로 뒤쳐지는 이유이다. 학자들은 이외에도 독서, 흥미유발, 시각적/청각적인 어휘단서 제공(위에서 말한 사회적 단서의 예이며, input quality라고도 한다. r^2=.1)29을 통해 좋은 어휘교육을 제공할 수 있다고 조언한다.

영상을 통한 교육은 좋을까? 적어도 많은 한국 부모는 그렇게 믿고 있다. 그래서 영어영상을 유투브로 보여주거나 영어영화를 보며, EBS에서는 아예 영어만 나오는 EBS를 만들었다. 그러나 이런 영상을 통한 교육은 실제로 언어학습에 도움이 되지 못한다. 한 연구30에서 연구자들은 미국아이들에게 중국어를 가르쳤는데, 직접 소통하며 가르친 경우에는 원어민에 비견될 정도로 효과가 좋았지만 티비로만 보거나 오디오만 들은 경우에는 변화가 없었다. 다른 연구31에서는 매체를 통한 교육이 효과가 있었지만, 영상이 아이들과의 상호작용을 감안하고 만들어진 경우에만 효과가 있었다.

학자들은 매체를 통한 교육의 효과 자체에 의문을 제기하는데, 왜냐하면 아이가 티비나 유투브와 같은 영상매체를 많이 접할수록 아이의 언어발달은 물론 신체/사회성 발달도 늦어지고 집행기능도 발달하지 못하기 때문이다. 또한 영상매체를 많이 보는 아이들은 과잉활동과 부주의를 더 많이 보고하는데, 이 두가지는 공교롭게도 ADHD의 3가지 주요 특성중 두개이다. 그리고 설사 영상매체에서 무언가를 배운다고 하더라도 아이들은 이것을 현실에 적용하는데 어려움을 느끼며, 이러한 video deficit effet는 특히 13-20개월 아기에게 더 심하다. 학자들은 아이들이 영상매체에만 빠져있느라 부모와의 상호작용이 적어져서 이런 일이 생긴다고 보는데, 실제로 부모의 영상매체 시청시간은 아이의 영상매체 시청시간과 정적으로 상관되어 있다. 물론 엄밀한 과학적 기반하에 제작된 교육 프로그램은 학습에 도움이 되지만, 전문가들은 나이가 어린 아기들에게는 유투브나 티비를 노출시켜선 안된다고 경고한다.

렉시콘과 어휘습득

렉시콘(lexicon, 어휘집)은 한 단어의 표상으로, 한 단어의 의미와 언어적 특성, 음성적 특성, 관련된 단어와의 연결 등을 합쳐서 말한다. 이러한 렉시콘은 인간이 어휘를 사용할때 필수적이며 그래서 언어능력과도 관련되어 있다. 학자들은 렉시콘의 습득에 대해 연구하기 위해 lexical decision task(classification task)를 고안했는데, 이 과제는 RT를 통해 인간의 언어습득에 영향을 미치는 요소를 연구한다. 이 과제를 시행할때 연구자들은 피험자에게 화면 중앙으로 초점을 모으게 한 후 단어를 띄워주고 이것이 실제 존재하는 단어인지 질문한다. 그리고 대답의 정확도와 RT를 측정한다. 이렇게 나온 정확도와 RT는 만약 연구자가 조작한 요인이 실제 언어습득에 중요하다면 실험군과 대조군 사이에 큰 차이를 보일 것이다.

lexical decision task를 통해 연구한 결과 렉시콘은 두가지 요인에 의해 잘 형성되는 것 같다. 먼저 렉시콘은 해당 단어에 많이 노출될수록 형성되기 쉽다. 이를 word frequency effect라 하는데 실제로 노출된 수가 많은 단어일수록 잘 재인된다. word frequency effect는 단어를 어릴때 들었을수록, 그리고 단어가 open-class인 경우 잘 나타난다. 여기서 open-class word는 새로 나타나거나 변형될 수 있는 단어로, 거의 모든 단어가 해당한다. 언뜻보면 변하지 않는 단어가 있을수 있는지 의문이지만 어떤 단어는 문법의 변화와 비슷한 속도로 변화한다. 은/는/이/가나 that, the, a는 쉽게 변하지 않는 단어들이다. 이것을 closed-class word라 하는데 closed-class word에서는 word frequency effect가 잘 나타나지 않는다. 그러나 비판자들은 closed-class word가 너무나도 높은 빈도로 쓰이기 때문에 word frequency effect가 안보이는 것 뿐이라고 반박한다. 또한 어린 나이에 들은 단어가 잘 기억되는 것은 모든 단어가 똑같은 영향력을 가지지만 단지 처음 배운 단어가 더 많은 노출을 경험해서(1년 빠른 단어라면 1년동안 더 많이 노출된다) 그렇게 보이는 것이라고 비판한다. 후자의 경우 아직도 논쟁이 일고 있다.

두번째 요인은 의미로, 다른 단어와 연결된 단어일수록 렉시콘이 쉽게 형성된다. 이를 semantic effect라 하는데, 연구자들은 semantic effect를 증명하기 위해 다양한 lexical decision task의 변형을 만들었다. 가장 고전적인 방법은 두 단어를 동시에 제시하고 두 단어 모두 맞는 단어인지 묻는 기법으로, 두 단어의 의미가 서로 연관되어 있을수록 점화가 일어나 RT가 작아지고 정확해진다.32 다른 연구자들은 두 단어를 순차적으로 제시하고 둘이 맞는 단어인지 물었으며, , 또다른 연구자는 한 단어는 시각(화면)적으로, 다른 단어는 청각적(헤드폰)으로 제시하고 두 단어가 맞는 단어인지 질문하였다.

가장 마지막에 언급된 방법론(cross-modal priming)은 다른 학자도 사용하였는데, 그는 이 방법을 통해 렉시콘의 형성에 영향을 미치는 다른 요인도 발견하였다. phonological effect는 단어의 음운적 특성이 서로 비슷할수록 렉시콘이 쉽게 형성되는 현상이다. 즉 당신이 '한글'을 알고 있다면, '한자'를 알기도 쉽다. 이를 증명한 실험에서 연구자는 kapitein(선장)과 geld(돈)를 같이 제시하고 RT를 측정하였다. 언뜻 보기에 이 두 단어는 어떠한 연결고리도 없는 것 같지만, 사실 이 단어는 kapitaal(자본)로 연결되어 있다. kapitaal은 geld와 의미가 비슷하지만, 동시에 kapitein과 음운적으로 비슷하다. 실험결과 kapitein은 semantic effect에 비해 약하긴 하지만 geld를 성공적으로 점화시켰다. 이러한 효과는 단어를 들려줄때 kapitein 전체를 들려줄 때보다 kapit-까지만 들려줬을때 더 강했으며 단어의 뒷부분이 비슷한 경우에는 나타나지 않았다. 전자의 경우 비슷한 음운만 남았을때 더 점화가 강하게 되어 나타나는 현상으로 보이며, 후자의 경우 두 단어의 음운적 유사점을 좀더 쉽게 알수 있도록 두 단어를 시각적으로 제시한 경우에는 역시 phonological effect가 나타났다.

여러 방식으로 형성된 렉시콘은 어떻게 형성되고 어떻게 재인될까? 이는 아직 미지의 영역이다. marslen-wilson과 welsh33는 cohort model을 제안했는데, 이 모델은 렉시콘이 access stage-selection stage-integration stage의 3단계를 거쳐 형성된다고 주장한다. 이 모델에 따르면 단어가 입력되면 먼저 access stage에서 단어의 음운적 정보가 분석되고 이를 토대로 이 단어일 것이라고 보이는 후보 단어들을 선별한다. 예를 들어 만약 'auto'란 말을 들었다면 음운적 특징이 비슷한 automobile, autodesk, automatone 등의 단어가 후보로 선별된다. 이렇게 후보가 선별되면 이제 selection stage에서 단어의 맥락이나 상황 등 다른 정보가 통합되어 후보를 더 간추린다. 이렇게 하여 최종적인 integration stage에서는 가장 올바른 단어가 선출되어 방금 들은 단어가 이 단어라고 인식하게 되며, 만약 아예 새로운 단어라면 이 단계에서 여러 정보가 통합되어 새로운 렉시콘으로 구성되게 된다.

렉시콘과 이중언어

이중언어에서 렉시콘의 구성은 좀더 복잡한 양상을 띈다. 왜냐하면 이중언어자는 하나의 대상을 지칭하는 두개의 단어를 알고 있기 때문이다. 학자들은 이중언어자의 뇌에서 렉시콘이 어떻게 처리되는지 연구해왔다. 첫번째 모델은 유창성에 따라 렉시콘의 활동 양상이 달라진다는 것으로, 어떤 단어를 들었을때 자신이 이미 유창한(그래서 렉시콘을 발달시킨) 언어의 렉시콘을 불러낸 뒤 이를 해당 언어로 번역한다는 것이다. 예를 들어 영어를 배우고 있는 한국어 화자가 'cat'이라는 말을 들으면, cat이 먼저 '고양이' 렉시콘을 활성화한후 렉시콘에 의해 cat이라는 단어가 머릿속에 떠오른다는 것이다. 이러한 경로는 두 언어에 모두 유창해질때 사라지며, 이 경우 두 언어에 독립적인 렉시콘이 생성된다.

이러한 가설은 실험적 증거에 의해 반박되었다. 그 대안으로 떠오른 정설은 이를 다르게 설명하는데, 현재 정설은 각각의 언어로 된 렉시콘이 있고 이중 하나가 억제된다는 것이다. 위의 상황을 예로 들면 cat을 들었을때 '고양이' 렉시콘과 'cat' 렉시콘이 동시에 활성화되고 이중 '고양이' 렉시콘이 억제(inhibition)되어 우리가 cat이라는 단어를 인지한다는 것이다. 여러 실험이 이를 지지했는데, 한 연구34에선 독일-영어 이중언어자에게 화면에 제시된 물체중 하나를 고르도록 했다. 화면에는 총 4가지의 물체가 있었는데 이중 하나는 영어로 desk이고 다른 하나는 독일어로 deskel(영어로는 lid)이어서 둘을 혼동할 소지가 있었다. 실험결과 이중언어자들은 유창성이나 주 언어에 상관없이 두 물체를 비슷한 횟수로 눌렀다. 다른 연구35에선 두 영어단어의 관계에 대해 응답하게 했는데, 각 영단어는 한자단어가 같이 붙어있었다. ERP 측정결과 영단어끼리의 관련이 없어도 한자단어끼리의 상관이 있을 경우 중국어 화자와 중국어-영어 이중언어자에게서 비슷한 패턴이 나타났다. 그러나 이런 효과는 실제 행동측정에서는 드러나지 않았다. 이 이론은 두가지를 예측한다. 먼저 하나는 억제 능력이 좋을수록 이중언어를 더 유창하게 구사한다는 예측이다. 그리고 다른 하나는, 이중언어자가 그 특성상 억제 능력을 발달시켜야 했기 때문에, 일반인보다 억제 능력이 더 뛰어날 것이라는 예측이다.

통사론(sentence processing)

문장의 구조에 대한 최초의 과학적 설명은 촘스키에게서 나왔다. 촘스키는 문장이 계층구조(tree structure)를 이루고 있다는 아이디어를 처음 제안했는데, 이에 따르면 문장은 명사구(Noun Phrase, NP)와 동사구(Verb Phrase, VP)로 구성되어 있고, NP는 각각 한정사(det)와 형용사, 명사로 구성되어 있는 반면 VP는 동사와 목적어(NP)로 구성되어 있다. 촘스키는 모든 문장이 이러한 계층적 구성을 가진다고 보았다.

이러한 구성은 실제 문장과 상당히 잘 들어맞지만, 다른 언어의 경우 예외사항이 생긴다. 먼저 한국어를 보면 한국어 문장에서는 VP만 존재하는 경우가 존재한다. '과일을 먹었다.'는 문법에 적합한 한국어 문장이지만 주어가 존재하지 않는다. 한국어 문장에서 주어가 생략되는 경우는 빈번하며 이럴 경우 대체로 문맥을 통해 생략된 주어를 유추하게 되는데 이는 에스파냐어에서도 나타난다. 또한 영어에서의 NP는 한정사+형용사+명사로 구성되어 있지만 때에 따라 명사+명사 형태의 구성도 가능하다. '따끈한 저녁 수프'는 '따끈한'과 '저녁'이 수프를 수식하고 있다. 그리고 한정사는 서구 언어에서 매우 일반적이지만 동양 언어에서는 관찰되지 않는다. 대신 동양 언어에는 명사 앞에 따라붙는 조사(cm)가 존재한다.

문장의 해석은 처음 발화된 문장이 귀에 들어오는 시점에서부터 시작된다. 이를 immediacy principle이라 하는데,36 이 원리에 따르면 인간은 문장이 귀에 들어오기 시작한 순간부터 매우 빠르게 문장을 조직화하고 뜻을 해석한다. 이러한 원리는 길 혼돈 문장(garden-path sentence)을 만들게 되는데, 길 혼돈 문장은 문장구조가 복잡하여 해석에 애를 먹는 문장이다. 예를 들어 '그녀는 모자를 쓰고 의자에 앉아있는 아이를 불렀다.'는 순간적으로 그녀가 모자쓴 아이를 부르는지, 자신이 모자를 쓰고 아이를 부르는지 헷갈리게 한다. 이런 헷갈림은 인간이 문장이 끝난 후부터 해석일 시작하는게 아니라 '그-'가 들리는 순간부터 문장을 해석하기 때문에 일어나는 오류이다. 이러한 오류는 어른들의 경우엔 매우 빠르게 해소되지만 immediacy principle 역시 증명한다.

그렇다면 이런 문장의 해석은 어떤 원리로 이뤄질까? 하나는 late closure strategy이다.37 이 원리에 따르면 문장에서 나타나는 구는 대개 가장 가까운 절에 속한 것으로 해석된다. 예를 들어 'kamehameha said that he declared the war for me yesterday.'는 'kamehameha said-'와 'he declared the war for me'라는 두개의 절로 구성되어 있다. 이런 경우 yesterday는 후자의 절에 가깝기 때문에 많은 사람들이 1차적으로 yesterday를 후자의 절에 속하는 것으로 해석한다. 다른 하나는 minimal attachment strategy로,38 이 원리에 따르면 문장은 가능한 한 가장 간단한 문법구조를 가진 것으로 해석된다. 이는 인지적 절약을 위한 것으로, 실제로 구나 절이 추가되어 더 문법적으로 더 복잡한 문장은 읽는데 더 많은 시간이 걸린다.

어떤 학자들은 이러한 문장의 해석이 단계적으로 이뤄지며 각 단계는 서로 독립되어 있다고 주장한다.(modular view of sentence processing) 이 이론에 따르면 문장의 해석은 3단계로 나눠진다. 1단계에서는 문장의 문법적 구조가 파악되고, 2단계에서는 문장의 의미가 해석되며, 3단계에서는 이것이 세상에 대한 실질적인 이해로 연결된다. 위에서 말한 문장 해석 원리는 모두 1단계에서 이뤄지며 문맥이나 어휘지식은 이 단계에 영향을 주지 못한다.

이 분야의 주요 연구자로는 frazier와 fodor가 있다. frazier와 fodor은 modular view를 제안하고 여러 문장 해석 원리를 발견했다.

interactive view

그러나 많은 학자들은 modular view에 반대한다. 이들은 constraint-based model의 지지자로, 이들에 따르면 문법적 해석과 의미 해석이 서로 단계적으로 분리된게 아니라 다같이 한번에 이뤄진다. 그리고 이것들은 문장의 의미를 특정한 형태로 제한하도록 하여 문장의 의미를 발견하도록 한다. 이들을 지지한 한 연구에서 피험자는 문장의 각 구가 적힌 화면을 순차적으로 제시받고 읽었는데, 문장의 초반은 the defandent라고 적혀있거나 the evidence라고 적혀있었다. 그 다음에 온 화면에는 examined라고 적혀있었는데, 문법적 특성상 evidence 뒤에 examined가 오면 evidence가 주어로 여겨지기 보다는 두 단어가 서로 다른 절이고 사이에 생략된 표현이 있다고 여겨진다. 그 다음엔 by the lawyer이 나왔고 이후 계속 구가 나왔는데, 단어를 읽는 RT를 측정한 결과 evidence 군에서 by the lawyer를 읽는 RT가 더 빨랐다. 이는 문장의 의미가 미리 제한된 경우 추가적인 인지적 처리가 없었다는 증거이며, 문장의 해석이 일종의 제한을 통한 과정이라는 모델의 예측과 일치한다.

다른 연구39에서 피험자는 다섯개의 물체가 제시된 그림에 노출되었는데, 이중 먹을 것은 케이크 하나 뿐이었다. 그림을 보고 있는 상태에서 피험자는 문장을 들었는데, 이 문장은 'I will eat/move the cake'로 아마 이를 들은 피험자는 시선이 케이크로 향했을 것이다. 이러한 시선의 움직임은 피험자에게 부착된 아이트래커를 통해 추적되었다. 실험결과 피험자는 역시나 케이크를 더 많이 쳐다봤는데, 동사가 eat이 제시된 경우 동사가 제시된 순간부터 케이크에 더 시선을 집중했다. 이는 피험자가 eat 다음에 cake가 와야 한다는 지식을 문장 해석에 반영했다는 뜻이며, 의미해석도 문법 해석 못지않게 빠르게 이뤄진다는 사실을 의미한다.

한편 constraint-satisfication model의 지지자들은 한 단어와 결부된 통사적/의미적 맥락이 단어의 해석을 제한한다고 본다. 실제로 다의어는 전체적인 문장의 맥락이 명확할 때 잘 해석된다.40 이것이 길 혼돈 문장을 만드는 원인일 수도 있는데, 가령 put은 대부분 전치구를 명사로 포함한 동사구의 형태로 오기 때문에 put 뒤에 붙는 전치사는 put의 수식어로 보통 해석된다. 이는 독립적인 전치구로 해석되는 on의 경향과 충돌하기 때문에 put - on - in/at - 과 같은 문장구조는 해석에 많은 혼선이 오게 된다. 이처럼 constraint-satisfication model은 길 혼돈 문장이 단어간 어휘적 경향의 불일치에서 생겨난다고 보며, 단어에 따른 경향성도 문장 해석에 관여한다고 한다.

이외에 학자들은 어떤 modifier의 존재가 문장 해석에 관여함을 밝혀냈다. 이들의 실험41에서 피험자는 냅킨 위의 개구리를 집으라고 지시를 받았는데, 첫번째 조건에는 개구리가 선택지에 하나밖에 없는 반면 두번째 조건에는 개구리가 2개 있었다. 두 조건 모두 빈 냅킨이 선택지로 있었는데, 실험결과 피험자는 두번째 조건에서 빈 냅킨을 보는 빈도가 매우 적었다. 정확히 피험자는 실험에서 'put the frog on the napkin'이라는 지시를 받았는데, 이 지시가 첫번째 조건에서는 개구리와 냅킨을 동시에 찾도록 만든 것이다. 반면 두번째 조건에서 개구리는 쉽게 눈에 띄였고, 복수의 개구리는 필연적으로 그 중 하나를 특정할 수식어(modifier)의 존재를 암시했기 때문에 뒤에 오는 냅킨이 하나의 수식어로 해석된 것이다. 이 경우에는 문장이 처한 상황 맥락이 문장의 해석에 영향을 끼쳤다.

지식, 어휘 경향, 맥락 등 다양한 요인이 문장 해석에 작용하지만, 이들이 모두 같이 작용한다는 것은 틀림없는 사실이다. 이들은 모두 문장의 해석이 제한된 방향으로 이뤄지도록 하여 문장의 의미가 추론되도록 만든다. 이러한 모델은 모든 요소가 따로 작용한다는 modular view에 반하며, 이처럼 문장 해석에 여러 요소가 함께 관여한다는 주장이 interactive view다. 현재 정설은 interactive view며, 이 관점은 통사론에서의 많은 데이터를 설명해준다.

LCM42

linguistic category model(LCM)은 언어의 해석에 대한 심리학 이론으로, 사람들이 의사소통을 하면서 사건을 어떻게 표현하고 전략적으로 언어행동을 조절하는지 설명하는 이론이다. 이 이론에서는 기존의 문법이나 의미론과 달리 단어들을 묘사 동사(Descriptive Action Verb, DAV), 해석 동사(Interpretative Action Verb, IAV), 상태행동 동사(State Action Verg, SAV), 상태동사(State Verb, SV), 형용사(ADJective, ADJ)로 구분한다.

DAV는 일어난 사건을 직접적으로 묘사하는 동사이고, IAV는 일어난 사건을 묘사하긴 하지만 보다 추상적으로 묘사한다. SAV와 SV는 DAV나 IAV와 달리 사건으로 인해 발생한 정서적 결과를 묘사하는데, SAV는 특정 사건으로 인해 발생한 정서를 묘사하는 반면 SV는 관찰이 불가능하며 일반적인 정서를 묘사한다. ADJ는 대상의 안정적이고 잘 변하지 않는 속성을 묘사하는 단어로, 이들은 추상성과 구체성에서 볼 때 DAV-IAV-SV-ADJ 순으로 추상적이다. 아래의 예시는 해당 단어들의 예시를 보여주고 있다.

그가 프라타를 먹었다.(DAV)

그가 프라타를 음미했다.(IAV)

그는 프라타를 먹고 환희를 느꼈다.(SAV)

그는 프라타를 좋아한다.(SV)

그는 미식가이다.(ADJ)

이 분야의 주요 연구자로는 semin과 rubini가 있다.

Design processes

LCM은 언어를 분석할 때 언어를 머릿속에 고정된 무언가로 상상하는 대신, 사람과 사람이 상호작용하는 상황에서 내외집단과 관련하여 전략적으로 사용하는 언어 도구로 보라고 제안한다. 가령 linguistic intergroup bias는 내집단의 긍정적인 행동이나 외집단의 부정적인 행동을 추상적인 단어로, 내집단의 부정적인 행동이나 외집단의 긍정적인 행동을 구체적인 단어로 묘사하는 현상을 말한다. 이는 전자를 추상적이고 불변하는 성향에 귀인하고, 후자를 구체적이고 가변적인 상황에 귀인한 결과로 볼 수 있다.

기존에 이러한 언어 사용은 화자의 동기와 인지에 초점을 두고 연구되었다. 그러나 LCM은 화자와 함께 청자에 대해서도 관심을 보인다. 가령 이에 대해서 수행된 어떤 연구들은, 이러한 언어 사용이 청자에게 서로 다른 효과를 가져온다는 점을 보여주었다. 이 연구43에서 청자는 화자가 긍정적인 행동을 추상적으로 표현할 때 화자와의 심리적 거리가 가까워졌고, 부정적인 행동을 추상적으로 표현할 때는 더 멀어졌다. 다른 연구44에서도 긍정적 행동에 대한 추상적 표현과 부정적 행동에 대한 구체적 표현은 심리적 근접성(proximity)을 키웠으며, 반대의 경우 심리적 거리가 증가했다.

이처럼 LCM은 언어가 어떻게 해석되는지에 관심을 가지고, 어떻게 행동에 영향을 끼치는지도 조사한다. 이는 LCM이 기존의 언어과학 이론에 대해 가지는 차이점이기도 하다. LCM은 언어가 사고를 표현하는 도구라고 본다. 그리고 언어를 생성하는 인간의 심리 기제가 언어를 통해 사람들의 사회적 사건 해석에 어떤 영향을 끼치고, 사회적 행동에 어떤 영향을 끼치는지 탐구하고자 한다.

LCM의 언어관

기존 언어 이론과 LCM은 언어관의 차이, 즉 언어의 본질에 대한 질문 ‘What is language?’에서부터 드러난다. 기존 이론의 질문은 ‘What is language?’인데, 이는 언어가 다른 대상과 시공간적 맥락에서 독립된 실재이고 그 자신만의 내적 법칙에 따라 작동한다고 간주하게 만든다. 이러한 접근은 사고(cognition)도 마찬가지로 대상에서 독립된 개별 실재라고 간주하게 만들며, 따라서 이러한 패러다임 하에서 학자들은 ‘언어와 사고가 어떻게 상호작용하는가?’와 같은 질문을 생성한다. 사실 언어와 사고의 관계에 대한 종래의 연구 접근이 이러한 기존 이론에 따른 접근의 결과라고 LCM의 지지자는 주장하며, 비교문화적 접근도 서로 ‘독립’된 두 사고방식을 가정하는 기존 이론의 접근이라고 LCM의 지지자는 얘기한다.

물론 그러한 접근도 많은 성과를 낳았지만, LCM의 지지자는 기존의 접근이 언어와 사고를 단순히 개인의 뇌 속에서 일어나는 기제로 한정했다는 한계를 가진다고 주장한다. 이에 따르면 서로 다른 언어 기제가 서로 독립된 신경회로를 구성한 채 점화되기만을 기다린다는 설명은, 그것들이 언제 점화되고 왜 점화되는지 잘 설명하기 어렵다. 또한 사회적 환경이 왜 그러한 기제를 발달시켰는지, 언어가 도구로서 실생활에서 어떻게 사용되는지도 파악하기 힘들다. 즉 언어가 상황과 시간에 따라 사용 양상이 변하는 모습을 파악하기 위해서는, 고정적인 기존 접근 대신 새로운 접근(LCM)을 택해야 한다고 LCM은 제안한다.

기존 이론과 달리 LCM의 질문은 'What is language for?'로, 언어 그 자체의 본성보다는 그것이 맥락에 비추어 작동하는 방식에 대한 질문이다. 이러한 관점에서 언어는 특정한 사용 맥락에서 화자의 사고를 전달(design process)하는 도구로, 그 목적은 주로 청자가 특정한 무언가에 주의를 기울이도록 만들기 위함이다. 이러한 가정 하에서 LCM 연구자들은 언어의 형태가 특정한 목적에 적응한 결과라고 보며, 화자가 언어를 조직하는 과정(production process)과, 청자가 언어를 해석하는 과정(comprehension process), 그리고 이를 통해 언어가 타인의 행동에 끼치는 영향을 연구한다.

관련 연구들

언어에 대한 이러한 관점 하에서, LCM 연구자들은 주로 대인동사(interpersonal verb)가 실제 언어사용에서 어떻게 청자의 주의를 끌어들이고 주제에 맞게 작동하는지(topicalization, perspectivization)45 연구했다. 여기서 주로 사용된 실험 기법을 question-answer paradigm이라 하는데,46 이 방법은 같은 질문을 동사만 다르게 조작해서 동사가 어떤 인지적 효과를 가져오는지 조사하는 방법이다.

이를 사용한 최초의 연구47에서는 동사를 action verb와 SV로 나누어 질문을 만들었는데, 그 결과 action verb로 만들어진 질문에 답한 피험자는 주로 질문의 주체(왜 '너'는 개를 좋아하니?)를 원인으로 하는 답변('내'가 이러이러해서)을 한 반면 SV로 된 질문에 답한 피험자는 주로 질문의 객체(왜 너는 '개'를 좋아하니?)를 원인으로 하는 답변('개'가 이러이러해서)을 했다. 후속연구48에서 이러한 효과는 피험자의 기분이 부정적일때는 잘 나타났지만, 기분이 좋거나 평범한 경우에는 잘 나타나지 않았다.

다른 연구는 질문이 추상적인 정도가 답변이 추상적인 정도에 영향을 끼쳤는데, 또한 위에서 살펴보았듯이 질문이 추상적인 정도는 화자와 청자의 심리적 거리에 영향을 끼치며 이는 질문이 담은 정서적 가치에 따라 달라진다.49 이러한 연구는 action verb를 구체적인 동사로, SV를 보다 추상적인 동사로 보고 수행되어는데, 이중 후자의 연구50는 피험자들에게 소음을 가해서 피험자들의 종결 욕구(need for closure)를 높인 상태로 실험을 했다. 이 실험에서 피험자들은 4개 주제를 다루는 총 32개의 질문이 실생활에서 얼마나 쓰이는지 순위를 매겼는데, 실험결과 소음에 노출되어 종결 욕구가 높았던 피험자들은 SV를 사용한 질문들에 더 높은 순위를 매겼으며 청자들도 실제로 보다 추상적인 답변을 내놓았다. 또한 청자들은 그러한 질문을 한 화자들에게 더 심리적 거리감을 느꼈고, 질문의 객체를 중심으로 답변을 했다. 이는 보다 자유로운 상호작용 상황에서도 재현되었다.

언어의 생리적 측면51

언어와 뇌의 관계는 뇌과학의 가장 잘 알려진 사례 중 하나이다. 언어를 담당하는 뇌부위는 뇌과학에서 가장 초창기에 발견된 뇌부위이기도 하다. 가장 유명한 두 영역은 브로카 영역과 베르니케 영역인데, 브로카 영역(broca's area)은 언어를 만들어내는 역할을 맡고, 베르니케 영역(wernicke's area)은 외부에서 입력된 언어를 이해하는 역할을 맡는다. 브로카 영역은 전두엽에 있고 베르니케 영역은 측두엽에 위치하나 브로카 영역의 위치도 측두엽에 가깝다.

그러나 현재 신경과학적 연구에 따르면 언어에 관여하는 신경 네트워크는 이보다 더 복잡하다. 예시로 브로카 영역과 베르니케 영역 모두 보통 좌뇌에 있지만, 우뇌도 언어처리에 일부 관여한다.52 비슷하게 소뇌도 언어처리에 일부 관여한다.53 또한 브로카 영역 안에서도 명사를 처리하는 영역과 동사를 처리하는 영역은 서로 다르다.54 암묵적 말하기(covert speech, inner speech, 내면 언어)의 경우 7명을 대상으로 한 연구55에서 암묵적 말하기와 말하기는 모두 supplementary motor area와 lateral premotor area, ACC, PCC, SPL, insula, occipital lobe, posterior superior temporal gyrus, middle temporal gyrus, supramarginal/angular gyri에서의 활동과 관련되었으나, 암묵적 말하기의 경우 1차 운동피질의 언어구사 관련 영역(MLT)이 활동하지 않았다고 보고했다. 반면 12명을 대상으로 한 다른 연구56에서는 좌측 motor area를 억제하자 암묵적 말하기도 약화되었다.

언어는 생각을 결정하는가?

언어는 사람의 생각에도 영향을 끼친다. 비록 언어가 인간의 생각을 결정한다는 인문학적 주장은 거짓임이 탄로났지만, 그럼에도 언어가 생각에 영향을 끼친다는 점은 많은 언어학자들이 인정한다. 관건은 정도이다. 언어가 인간의 생각에 끼치는 영향은 제한적이며, 언어가 생각을 결정한다는 인문학자들의 주장은 그냥 망상이다. 또한 언어의 영향은 가역적이어서, 프라이밍을 통해 언어가 생각에 끼치는 영향을 역전시키거나 다른 방식으로 재현하는 것이 가능하다.57 그리고 인간을 대상으로 한 연구는 아니지만, LLM의 경우 언어에 따라 다른 사고를 거치지는 않는다.#

수어(수화)

수어(sign language)는 수화 언어의 준말로, 청각적 자극없이 손을 이용하여 상호작용하는 언어를 말한다. 나라마다 다른 수화가 존재하며 어떤 수어는 자생적으로 발생한다. 자체적인 문법이 존재하기 때문에 수신호와 구분해야 하며, 음소를 표현하는 지문자(fingerspelling)를 사용하여 단어를 표현할 수도 있지만 대부분의 어휘는 청각적 음소와 상관없이 존재한다.

과거에는 수어가 언어가 아니라는 게 정설이었지만58 현재 언어심리학자들은 수어도 언어임을 인정하고 있다.59 이는 수어에서 나타나는 각종 미세한 손짓이 음소의 역할을 한다는 발견에서 시작되었다.60 이후 학자들은 음소 이외에도 문법의 형태론적, 통사론적 구조가 수어에도 존재함을 발견하였으며61 recursive rule도 존재함을 발견하였다. 현재 많은 학자들은 수어의 독특한 문법적 특성과 음성 언어와의 유사성62에 대해 연구하고 있다.63 한편 다른 학자들은 수어의 독특한 발생에 중점을 두는데, 수어는 대개 음성 언어와 다른 매체를 사용하며 간혹 음성 언어의 어떠한 영향도 없이 자생하는 경우도 있다.64 이러한 특성으로 인해 모든 언어에 통용되는 보편 문법(universal grammar)이 있다고 주장하는 학자들은 수어를 연구하여 보편 문법의 특성을 발견하고자 하였다.65

- Harari,'사피엔스',조현욱 역,김영사,2015 [본문으로]

- Schactor 외 2명,'심리학 입문(2판)',민경환 외 8명 역,시그마프레스,2015,pp294-295 [본문으로]

- Nadasdy, A. (1995). Phonetics, Phonology, and Applied Linguistics. Annual Review of Applied Linguistics, 15, 63-80. [본문으로]

- Cheney, D., & Seyfarth, R. (1990). Attending to behaviour versus attending to knowledge: Examining monkeys' attribution of mental states. Animal behaviour, 40(4), 742-753. [본문으로]

- Von Frisch, K. (1974). Decoding the language of the bee. Science, 185(4152), 663-668;Kirchner, W. H., & Towne, W. F. (1994). The sensory basis of the honeybee’s dance language. Scientific American, 270(6), 74-80. [본문으로]

- Jarvella, R. J. (1970). Effects of syntax on running memory span d for connected discourse. Psychonomic Science, 19(4), 235-236;Jarvella, R. J. (1971). Syntactic processing of connected speech. Journal of verbal learning and verbal behavior, 10(4), 409-416;Sachs, J. S. (1967). Recognition of semantic, syntactic and lexical changes in sentences. Psychonomic Bulletin. [본문으로]

- Bock, K. (1990). Structure in language: Creating form in talk. American Psychologist, 45(11), 1221. [본문으로]

- Sandler, W., Aronoff, M., Meir, I., & Padden, C. (2011). The gradual emergence of phonological form in a new language. Natural language & linguistic theory, 29(2), 503-543 [본문으로]

- Bialystok, E., & Hakuta, K. (1994). In other words. New York: Basic Books;Hakuta, K. (1986). Cognitive development of bilingual children;Hakuta, K. (1999). The debate on bilingual education. [본문으로]

- Portocarrero, J. S., Burright, R. G., & Donovick, P. J. (2007). Vocabulary and verbal fluency of bilingual and monolingual college students. Archives of Clinical Neuropsychology, 22(3), 415-422. [본문으로]

- Nicoladis, E., & Genesee, F. (1997). Language development in preschool bilingual children. [본문으로]

- Campbell, R., & Sais, E. (1995). Accelerated metalinguistic (phonological) awareness in bilingual children. British Journal of Developmental Psychology, 13(1), 61-68;Bialystok, E. (1999). Cognitive complexity and attentional control in the bilingual mind. Child development, 70(3), 636-644;Bialystok, E. (2009). Bilingualism: The good, the bad, and the indifferent. Bilingualism, 12(1), 3. [본문으로]

- Mechelli, A., Crinion, J. T., Noppeney, U., O'Doherty, J., Ashburner, J., Frackowiak, R. S., & Price, C. J. (2004). Structural plasticity in the bilingual brain. Nature, 431(7010), 757-757. [본문으로]

- Stein, M., Federspiel, A., Koenig, T., Wirth, M., Lehmann, C., Wiest, R., ... & Dierks, T. (2009). Reduced frontal activation with increasing 2nd language proficiency. Neuropsychologia, 47(13), 2712-2720. [본문으로]

- Mechelli, A., Crinion, J. T., Noppeney, U., O'Doherty, J., Ashburner, J., Frackowiak, R. S., & Price, C. J. (2004). Structural plasticity in the bilingual brain. Nature, 431(7010), 757-757. [본문으로]

- Kuhl, P. K., & Miller, J. D. (1978). Speech perception by the chinchilla: Identification functions for synthetic VOT stimuli. The Journal of the Acoustical Society of America, 63(3), 905-917 [본문으로]

- Burnham, D., & Dodd, B. (2004). Auditory–visual speech integration by prelinguistic infants: Perception of an emergent consonant in the McGurk effect. Developmental Psychobiology: The Journal of the International Society for Developmental Psychobiology, 45(4), 204-220. [본문으로]

- Eimas, P. D., Siqueland, E. R., Jusczyk, P., & Vigorito, J. (1971). Speech perception in infants. Science, 171(3968), 303-306. [본문으로]

- Kuhl, P. K., & Miller, J. D. (1978). Speech perception by the chinchilla: Identification functions for synthetic VOT stimuli. The Journal of the Acoustical Society of America, 63(3), 905-917 [본문으로]

- Burnham, D., & Dodd, B. (2004). Auditory–visual speech integration by prelinguistic infants: Perception of an emergent consonant in the McGurk effect. Developmental Psychobiology: The Journal of the International Society for Developmental Psychobiology, 45(4), 204-220. [본문으로]

- Kuhl, P. K., & Miller, J. D. (1978). Speech perception by the chinchilla: Identification functions for synthetic VOT stimuli. The Journal of the Acoustical Society of America, 63(3), 905-917 [본문으로]

- Curtiss, S. (2014). Genie: a psycholinguistic study of a modern-day wild child. Academic Press. [본문으로]

- Johnson, J. S., & Newport, E. L. (1989). Critical period effects in second language learning: The influence of maturational state on the acquisition of English as a second language. Cognitive psychology, 21(1), 60-99. [본문으로]

- Bloch, C., Kaiser, A., Kuenzli, E., Zappatore, D., Haller, S., Franceschini, R., ... & Nitsch, C. (2009). The age of second language acquisition determines the variability in activation elicited by narration in three languages in Broca’s and Wernicke’s area. Neuropsychologia, 47(3), 625-633. [본문으로]

- Johnson, E. K., & Jusczyk, P. W. (2001). Word segmentation by 8-month-olds: When speech cues count more than statistics. Journal of memory and language, 44(4), 548-567 [본문으로]

- Johnson, E. K., & Jusczyk, P. W. (2001). Word segmentation by 8-month-olds: When speech cues count more than statistics. Journal of memory and language, 44(4), 548-567 [본문으로]

- Yuan, S., Fisher, C., & Snedeker, J. (2012). Counting the nouns: Simple structural cues to verb meaning. Child development, 83(4), 1382-1399 [본문으로]

- Byers‐Heinlein, K., & Werker, J. F. (2009). Monolingual, bilingual, trilingual: infants' language experience influences the development of a word‐learning heuristic. Developmental science, 12(5), 815-823 [본문으로]

- Cartmill, E. A., Armstrong, B. F., Gleitman, L. R., Goldin-Meadow, S., Medina, T. N., & Trueswell, J. C. (2013). Quality of early parent input predicts child vocabulary 3 years later. Proceedings of the National Academy of Sciences, 110(28), 11278-11283. [본문으로]

- Kuhl, P. K., Tsao, F. M., & Liu, H. M. (2003). Foreign-language experience in infancy: Effects of short-term exposure and social interaction on phonetic learning. Proceedings of the National Academy of Sciences, 100(15), 9096-9101 [본문으로]

- Linebarger, D. L., & Walker, D. (2005). Infants’ and toddlers’ television viewing and language outcomes. American behavioral scientist, 48(5), 624-645. [본문으로]

- Meyer, D. E., & Schvaneveldt, R. W. (1971). Facilitation in recognizing pairs of words: evidence of a dependence between retrieval operations. Journal of experimental psychology, 90(2), 227 [본문으로]

- Marslen-Wilson, W. D., & Welsh, A. (1978). Processing interactions and lexical access during word recognition in continuous speech. Cognitive psychology, 10(1), 29-63 [본문으로]

- Weber, A., & Cutler, A. (2004). Lexical competition in non-native spoken-word recognition. Journal of Memory and Language, 50(1), 1-25. [본문으로]

- Thierry, G., & Wu, Y. J. (2007). Brain potentials reveal unconscious translation during foreign-language comprehension. Proceedings of the National Academy of Sciences, 104(30), 12530-12535. [본문으로]

- Just, M. A., & Carpenter, P. A. (1980). A theory of reading: From eye fixations to comprehension. Psychological review, 87(4), 329. [본문으로]

- Frazier, L., & Fodor, J. D. (1978). The sausage machine: A new two-stage parsing model. Cognition, 6(4), 291-325. [본문으로]

- Frazier, L., & Fodor, J. D. (1978). The sausage machine: A new two-stage parsing model. Cognition, 6(4), 291-325. [본문으로]

- Altmann, G. T., & Kamide, Y. (1999). Incremental interpretation at verbs: Restricting the domain of subsequent reference. Cognition, 73(3), 247-264. [본문으로]

- Vu, H., Kellas, G., Metcalf, K., & Herman, R. (2000). The influence of global discourse on lexical ambiguity resolution. Memory & cognition, 28, 236-252. [본문으로]

- Trueswell, J. C., Sekerina, I., Hill, N. M., & Logrip, M. L. (1999). The kindergarten-path effect: Studying on-line sentence processing in young children. Cognition, 73(2), 89-134. [본문으로]

- Van Lange, P. A., Higgins, E. T., & Kruglanski, A. W. (2011). Handbook of theories of social psychology. Handbook of Theories of Social Psychology, 1-568 [본문으로]

- Reitsma-van Rooijen, M., Semin, G. R., & Van Leeuwen, E. (2007). The effect of linguistic abstraction on interpersonal distance. European Journal of Social Psychology, 37(5), 817-823 [본문으로]

- Rubini, M., & Kruglanski, A. W. (1997). Brief encounters ending in estrangement: Motivated language use and interpersonal rapport in the question–answer paradigm. Journal of Personality and Social Psychology, 72(5), 1047 [본문으로]

- Kukatova, O., Isakova, R., Ranucha, A., Otazhonova, F., & Begmatova, N. (2021). Typology of Semantic Roles of Actants and Predicates in Contemporary Linguistic Science. Annals of the Romanian Society for Cell Biology, 5960-5974 [본문으로]

- Semm, G. R., Rubinm, M., & Fiedler, K. (1995). The answer is in the question: The effect of verb causality on locus of explanation. Personality and Social Psychology Bulletin, 21(8), 834-841. [본문으로]

- Semm, G. R., Rubinm, M., & Fiedler, K. (1995). The answer is in the question: The effect of verb causality on locus of explanation. Personality and Social Psychology Bulletin, 21(8), 834-841. [본문으로]

- Matovic, D., & Forgas, J. P. (2018). The answer is in the question? Mood effects on processing verbal information and impression formation. Journal of Language and Social Psychology, 37(5), 578-590 [본문으로]

- Reitsma-van Rooijen, M., Semin, G. R., & Van Leeuwen, E. (2007). The effect of linguistic abstraction on interpersonal distance. European Journal of Social Psychology, 37(5), 817-823;Rubini, M., & Kruglanski, A. W. (1997). Brief encounters ending in estrangement: Motivated language use and interpersonal rapport in the question–answer paradigm. Journal of Personality and Social Psychology, 72(5), 1047 [본문으로]

- Rubini, M., & Kruglanski, A. W. (1997). Brief encounters ending in estrangement: Motivated language use and interpersonal rapport in the question–answer paradigm. Journal of Personality and Social Psychology, 72(5), 1047 [본문으로]

- Schacter 외 2인,'심리학 입문(2)',민경환 외 2인 역,시그마프레스,p303 [본문으로]

- Jung-Beeman, M. (2005). Bilateral brain processes for comprehending natural language. Trends in cognitive sciences, 9(11), 512-518. [본문으로]

- Murdoch, B. E. (2010). The cerebellum and language: historical perspective and review. Cortex, 46(7), 858-868. [본문으로]

- Cappelletti, M., Fregni, F., Shapiro, K., Pascual-Leone, A., & Caramazza, A. (2008). Processing nouns and verbs in the left frontal cortex: a transcranial magnetic stimulation study. Journal of cognitive neuroscience, 20(4), 707-720. [본문으로]

- Huang, J., Carr, T. H., & Cao, Y. (2002). Comparing cortical activations for silent and overt speech using event‐related fMRI. Human brain mapping, 15(1), 39-53. [본문으로]

- Aziz-Zadeh, L., Cattaneo, L., Rochat, M., & Rizzolatti, G. (2005). Covert speech arrest induced by rTMS over both motor and nonmotor left hemisphere frontal sites. Journal of cognitive neuroscience, 17(6), 928-938. [본문으로]

- 가령 Tse, C. S., & Altarriba, J. (2008). Evidence against linguistic relativity in Chinese and English: A case study of spatial and temporal metaphors. Journal of Cognition and Culture, 8(3-4), 335-357. [본문으로]

- Bloomfield, L. (1933). Language. New York: Holt. [본문으로]

- Stokoe Jr, W. C. (1960). Sign language structure: An outline of the visual communication systems of the American deaf. Journal of deaf studies and deaf education, 10(1), 3-37;Sandler, W., Aronoff, M., Meir, I., & Padden, C. (2011). The gradual emergence of phonological form in a new language. Natural language & linguistic theory, 29(2), 503-543 [본문으로]

- Stokoe Jr, W. C. (1960). Sign language structure: An outline of the visual communication systems of the American deaf. Journal of deaf studies and deaf education, 10(1), 3-37;Liddell, S. K., & Johnson, R. E. (1989). American sign language: The phonological base. Sign language studies, 64(1), 195-277 [본문으로]

- Klima, E. S., & Bellugi, U. (1979). The signs of language. Harvard University Press [본문으로]

- Aronoff, M., Meir, I., & Sandler, W. (2005). The paradox of sign language morphology. Language, 81(2), 301 [본문으로]

- Evans, N., & Levinson, S. C. (2009). The myth of language universals: Language diversity and its importance for cognitive science. Behavioral and brain sciences, 32(5), 429-448;Grosjean, F., & Lane, H. (1977). Pauses and syntax in American sign language. Cognition, 5(2), 101-117;Meir, I. (2002). A cross-modality perspective on verb agreement. Natural Language & Linguistic Theory, 20(2), 413-450 [본문으로]

- Sandler, W., Aronoff, M., Meir, I., & Padden, C. (2011). The gradual emergence of phonological form in a new language. Natural language & linguistic theory, 29(2), 503-543 [본문으로]

- Lillo-Martin, D. C. (1991). Universal grammar and American sign language. In Universal Grammar and American Sign Language. Springer, Dordrecht. 1-48 [본문으로]

'지식사전 > 기타' 카테고리의 다른 글

| 기억인지신경과학 정리 (2) | 2023.01.18 |

|---|---|

| 뇌과학 총론 (1) | 2022.12.16 |

| 전뇌의 이해 (1) | 2022.11.11 |

| 과학적 방법론 개론 (0) | 2022.09.09 |

| 분자 및 세포신경과학 총론 (1) | 2022.09.09 |